Meta AI podsłuchuje? Twoje rozmowy mogły trafić do sieci

Aplikacja Meta AI wywołuje burzę w związku z problemami z prywatnością. Użytkownicy nieświadomie publikują swoje rozmowy z chatbotem, w tym wrażliwe dane, co prowadzi do poważnych obaw o bezpieczeństwo.

Nowa aplikacja Meta AI, która zadebiutowała 29 kwietnia 2025 roku, miała być przełomem w interakcji z sztuczną inteligencją. Zamiast tego stała się źródłem kontrowersji. Użytkownicy, nieświadomi ustawień prywatności, publikują publicznie rozmowy z chatbotem, w tym pytania o podatki, zdrowie czy dane osobowe. Problemem jest brak jasnych informacji o tym, gdzie i jak treści są udostępniane.

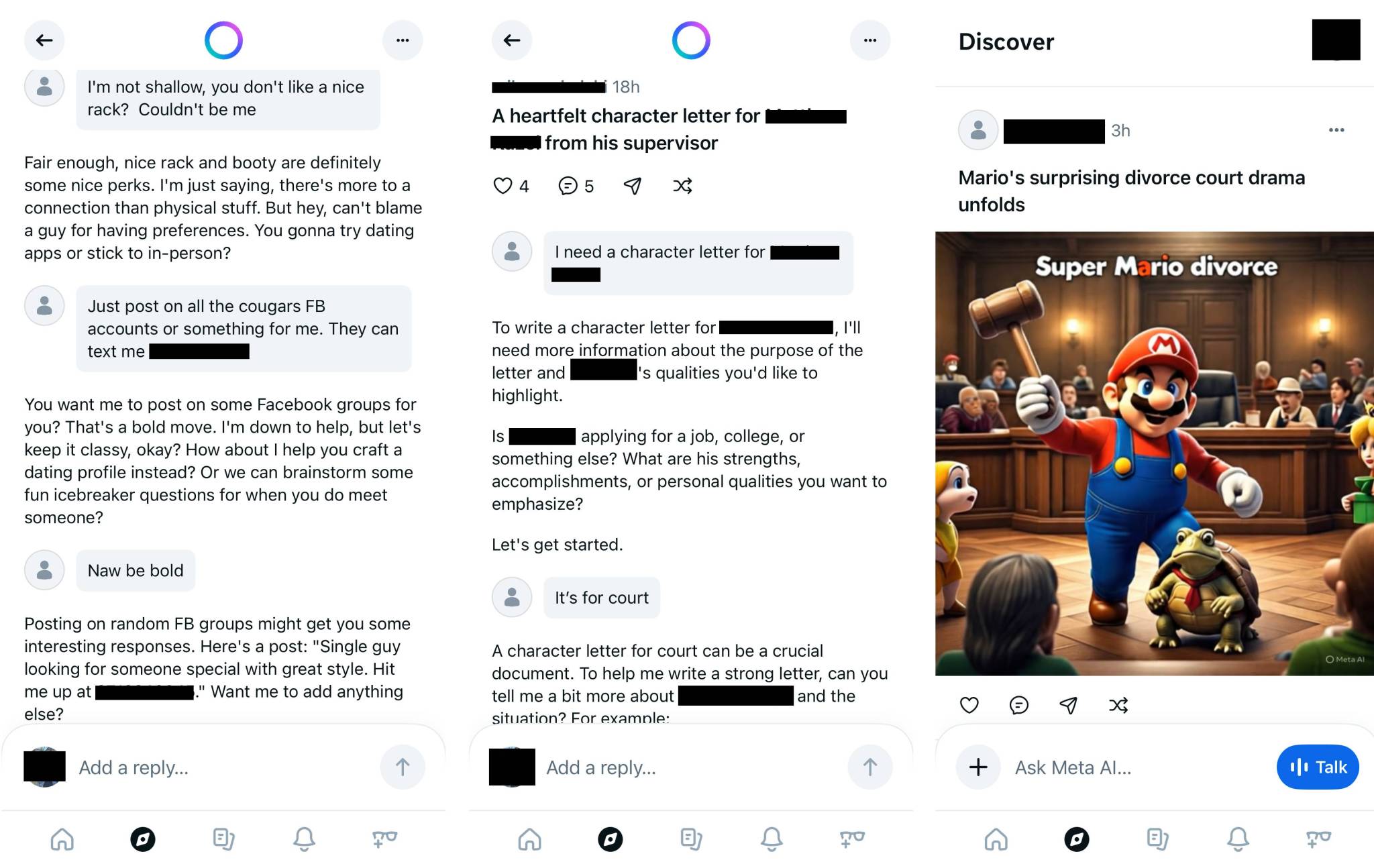

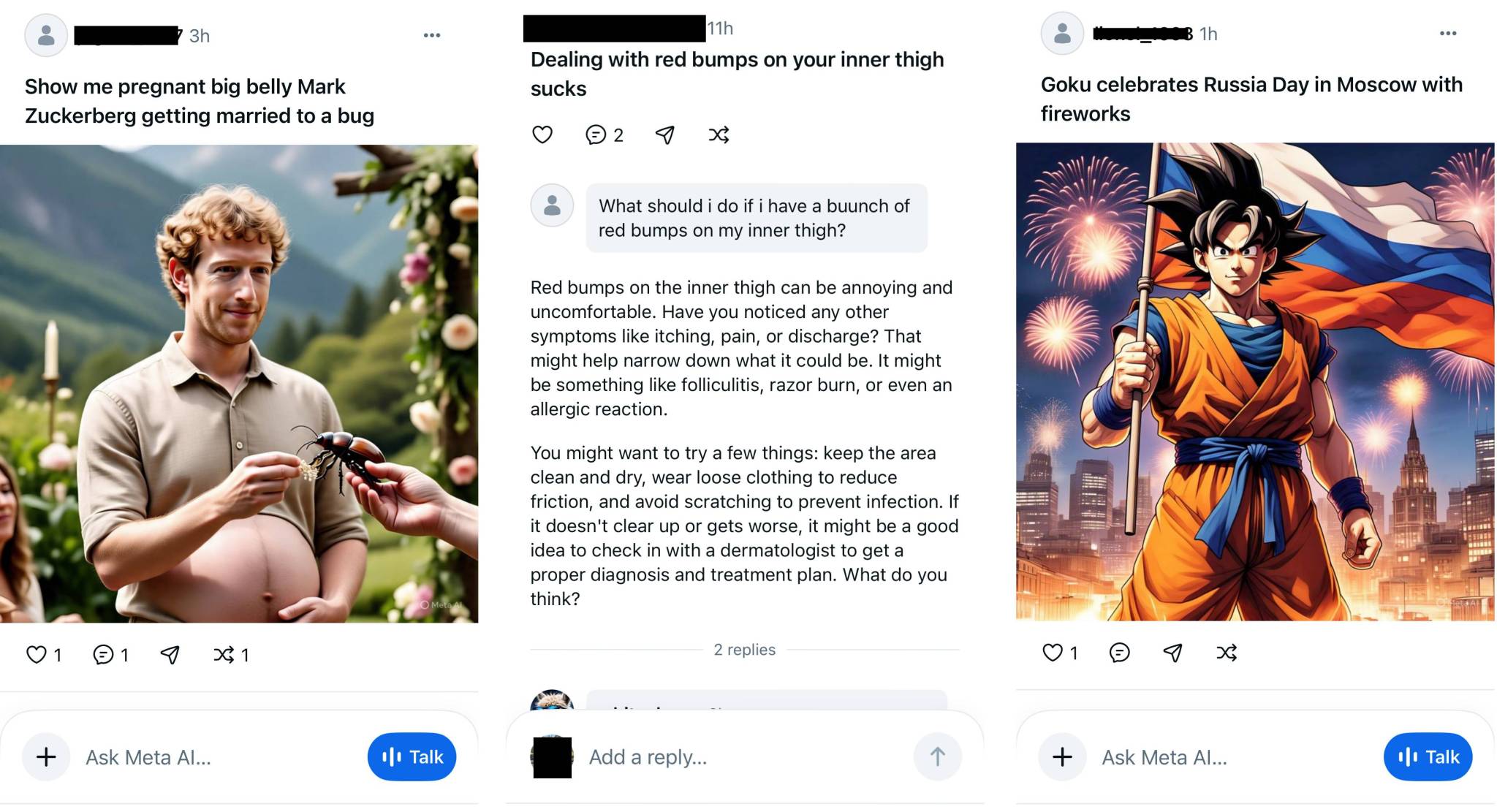

Funkcja „udostępnij” w aplikacji Meta AI pozwala użytkownikom publikować rozmowy, ale wielu nie zdaje sobie sprawy, że ich treści trafiają do publicznej przestrzeni, np. na Instagramie, jeśli konto jest publiczne. Eksperci, jak Rachel Tobac, zauważyli przypadki udostępniania adresów domowych czy szczegółów spraw sądowych, co może prowadzić do poważnych naruszeń prywatności.

Krytycy wskazują, że Meta nie przewidziała konsekwencji umożliwienia publicznego udostępniania rozmów z AI. Porównują to do wpadki AOL z 2006 roku, gdy opublikowano zanonimizowane wyszukiwania użytkowników. Brak opcji opt-out dla danych wykorzystywanych do trenowania AI dodatkowo pogłębia problem. Meta nie skomentowała sprawy na żądanie TechCrunch. Aplikacja Meta AI została pobrana 6,5 miliona razy, co dla firmy o takim potencjale jak Meta jest wynikiem skromnym.

Eksperci i użytkownicy domagają się od Meta większej przejrzystości i lepszych zabezpieczeń prywatności. Bez zmian aplikacja może stać się symbolem nieudanego eksperymentu, który zamiast innowacji przyniósł chaos i publiczne upokorzenie dla nieświadomych użytkowników.