Co nas czeka w 2050 roku? Jakie kosmiczne technologie szykują giganci branży? Fakty i ciekawostki

Ludzka percepcja czasu obarczona jest fundamentalnym błędem poznawczym: rzutujemy przeszłość na przyszłość w sposób liniowy, spodziewając się zmian umiarkowanych, jedynie "nieco szybszych i nieco tańszych". Tymczasem rozwój technologiczny nie kroczy, lecz biegnie po krzywej wykładniczej, co czyni prostą arytmetykę bezużyteczną. Przepaść dzieląca nas od roku 2050 nie będzie lustrzanym odbiciem dystansu, jaki pokonaliśmy od ery telefonów klawiszowych i raczkującego internetu do dzisiejszej wszechobecnej cyfryzacji. Czeka nas skok o niespotykanej dotąd amplitudzie, wynikający z faktu, że współczesne narzędzia inżynieryjne - od sztucznej inteligencji po zaawansowane symulacje - same zaczynają projektować swoje nowocześniejsze wersje, radykalnie zagęszczając czas potrzebny na kolejne przełomy.

Przyszłość nie jest materią dla wróżbitów, lecz dla księgowych i inżynierów największych korporacji świata. To, co w powszechnym mniemaniu uchodzi za fantastykę naukową, w dokumentach finansowych gigantów technologicznych widnieje jako konkretna pozycja budżetowa z precyzyjnym terminem realizacji. Mowa o nakładach na badania i rozwój, które swą skalą przewyższają budżety obronne wielu mocarstw, a ich celem nie jest mglista eksploracja, lecz wdrożenie rozwiązań, które dziś wydają się nieosiągalne. Komputery kwantowe czy fuzja jądrowa nie są marzeniami, lecz opłaconymi projektami, które mają zdefiniować infrastrukturę połowy stulecia.

W niniejszym opracowaniu odrzucamy zatem infantylne wizje rodem z popkultury na rzecz chłodnej analizy twardych danych i planów wdrożeniowych. Skupimy się wyłącznie na fundamentach cywilizacyjnych, które w nadchodzących dekadach staną się tak przezroczyste i niezbędne, jak dzisiejsza elektryfikacja. Naszą podróż rozpoczniemy od technologii obliczeniowych, ponieważ dotychczasowy porządek oparty na krzemie właśnie dociera do granic praw fizyki, wymuszając redefinicję samej istoty komputera.

Architektura post-krzemowa. Kiedy fizyka mówi "sprawdzam"

Fundament naszej cyfrowej cywilizacji kruszeje. Prawo Moore’a, które przez dekady gwarantowało nam regularne podwajanie mocy obliczeniowej, nie jest prawem natury, lecz obserwacją inżynieryjną, która właśnie zderza się z nieubłaganą fizyką kwantową. Tranzystory w procesorach zbliżają się do wielkości pojedynczych atomów. Dalsza miniaturyzacja w oparciu o krzem staje się niemożliwa z powodu zjawiska tunelowania elektronów. Mówiąc wprost - tradycyjny komputer dochodzi do ściany wydajności. Aby rok 2050 mógł zaistnieć w kształcie, jaki przewidujemy, musimy zmienić sam budulec technologii.

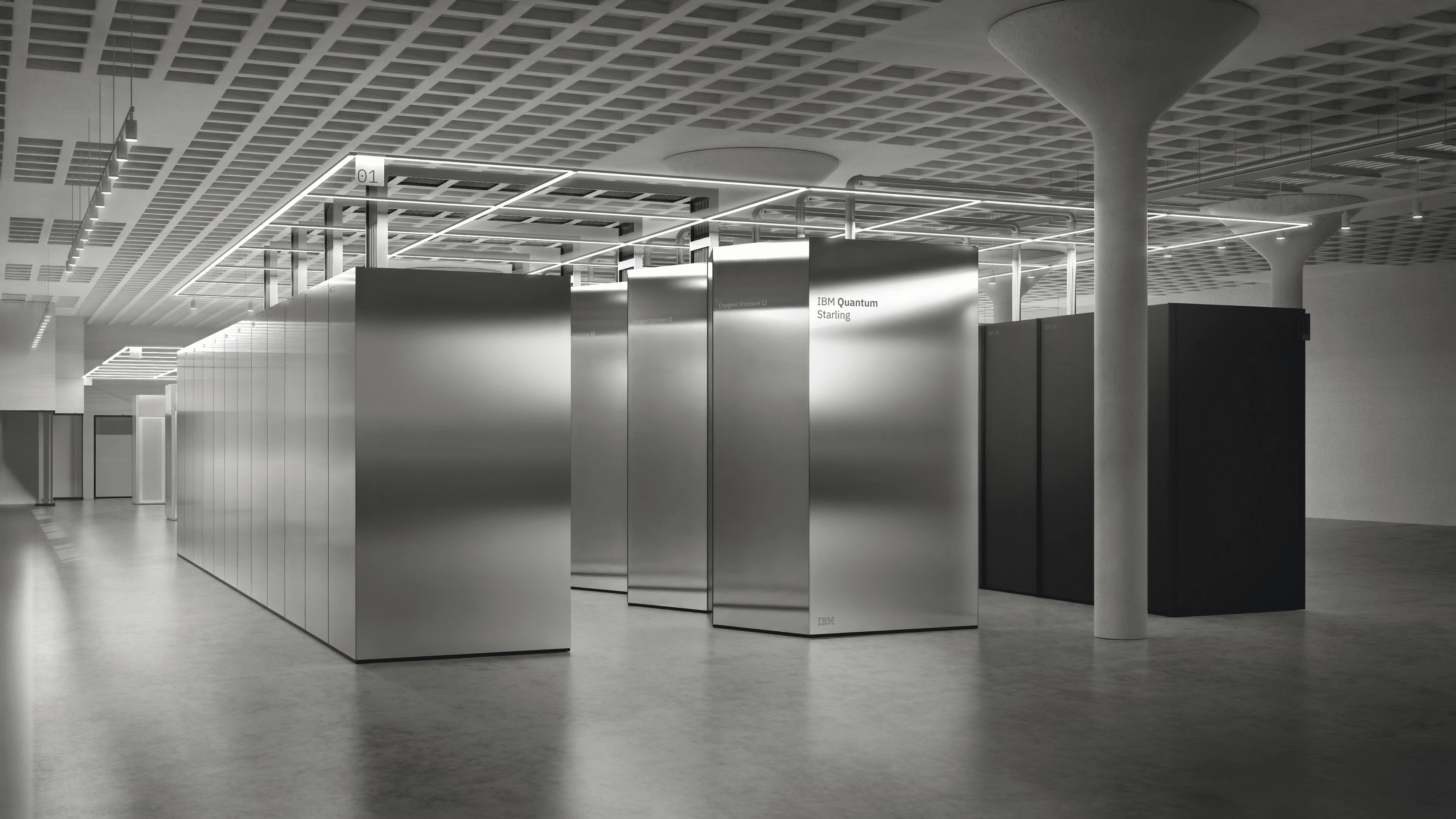

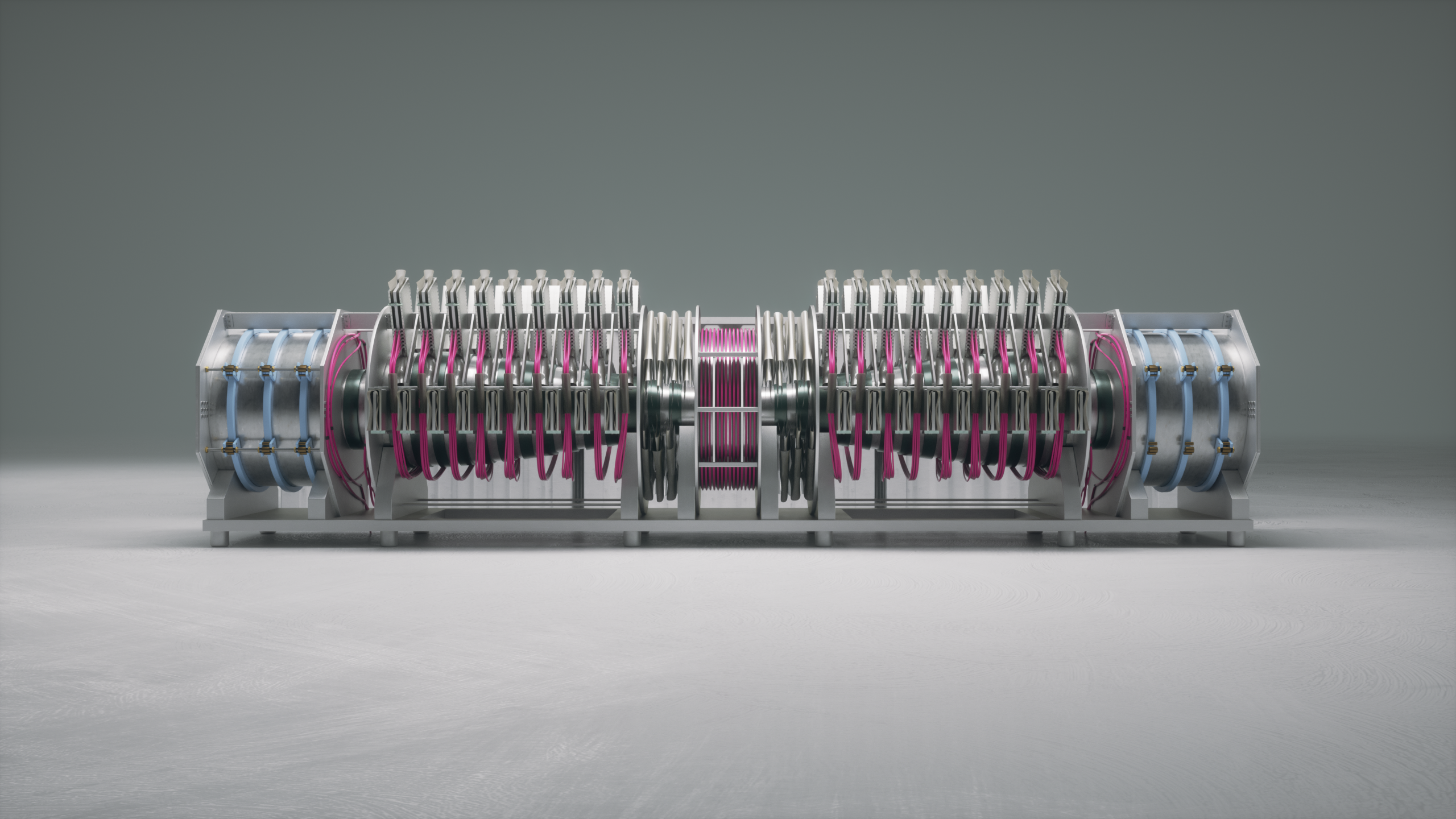

Odpowiedź leży w laboratoriach IBM, które realizują obecnie najbardziej transparentny i ambitny harmonogram rozwoju komputerów kwantowych na świecie. Mówię o precyzyjnie rozpisanej inżynierii. IBM odszedł od etapu eksperymentalnego (reprezentowanego przez procesory Eagle czy Osprey) i wszedł w fazę użytkową z układem Heron. Kluczowa jest tu jednak data 2033. To wtedy, zgodnie z oficjalnym planem, ma powstać superkomputer o nazwie Blue Jay, zdolny do wykonania nie milionów, a aż miliarda operacji kwantowych. W perspektywie roku 2050 oznacza to całkowitą zmianę paradygmatu: symulowanie nowych materiałów (np. nadprzewodników działających w temperaturze pokojowej) czy leków nie będzie trwało latami w laboratoriach, lecz godziny w chmurze obliczeniowej. Szyfrowanie, na którym opieramy dzisiejszą bankowość, stanie się bezużyteczne, co wymusi przejście na kryptografię post-kwantową - proces ten, choć niewidoczny dla laika, jest już wdrażany przez instytucje finansowe.

Równie krytycznym, a często pomijanym aspektem, jest trwałość naszej cyfrowej pamięci. Współczesne nośniki danych są efemeryczne - dyski magnetyczne i półprzewodnikowe (czyli SSD) ulegają degradacji po maksymalnie kilkunastu latach. Bez interwencji, wiedza zgromadzona przez ludzkość w XXI wieku mogłaby zniknąć szybciej niż papirusy. Rozwiązaniem, które w 2050 roku będzie standardem archiwizacji, jest technologia rozwijana obecnie w ramach inicjatywy Project Silica przez Microsoft.

Inżynierowie z Redmond wykorzystują lasery femtosekundowe (emitujące impulsy trwające jedną biliardową część sekundy) do trwałego grawerowania danych wewnątrz płytek ze szkła kwarcowego. Nie jest to zapis na powierzchni, lecz zmiana struktury materiału w trójwymiarze. Taka płytka, wielkości podstawki pod napój, jest odporna na gotowanie we wrzątku, pieczenie w piekarniku, mikrofale i silne pole magnetyczne. Jej trwałość szacuje się na 10 tysięcy lat. Centra danych w przyszłości przestaną być hałaśliwymi halami pełnymi wymieniających się talerzy magnetycznych, a staną się cichymi bibliotekami ze szkła, przechowującymi "cyfrowy kod genetyczny" naszej cywilizacji bez ryzyka utraty choćby jednego bitu.

Słońce zamknięte w reaktorze czyli energetyka

Wzrost mocy obliczeniowej, o którym mowa była wcześniej, generuje prozaiczny, lecz brutalny problem: głód energetyczny. Centra danych napędzające sztuczną inteligencję już dziś konsumują tyle prądu, co średniej wielkości państwa, a zapotrzebowanie to rośnie w tempie, którego nie są w stanie zaspokoić ani konwencjonalne elektrownie węglowe, ani kapryśne źródła odnawialne zależne od wiatru i słońca. Aby cywilizacja nie utknęła w energetycznym klinczu, potrzebujemy źródła stabilnego, bezemisyjnego i niemal nieskończonego. Odpowiedzią jest synteza jądrowa - proces, który napędza gwiazdy, a który po dekadach obietnic wreszcie wchodzi w fazę komercjalizacji.

Należy tu dokonać wyraźnego rozróżnienia, często zacieranego w publicznym dyskursie. Nie mówimy o rozszczepieniu atomu, znanego z Czarnobyla czy Fukushimy, gdzie powstają radioaktywne odpady o długim okresie połowicznego rozpadu. Mowa o fuzji - łączeniu lekkich pierwiastków (zazwyczaj izotopów wodoru), co uwalnia potężne ilości energii bez ryzyka stopienia rdzenia i bez produkcji długowiecznych odpadów. Do niedawna była to domena akademickich dywagacji, gdzie żartowano, że fuzja jest "zawsze 30 lat przed nami". Ten żart przestał być aktualny w momencie podpisania pierwszego w historii komercyjnego kontraktu na odbiór takiej energii.

Kluczowym graczem jest tutaj spółka Helion Energy, która zamiast gigantycznych, międzynarodowych projektów badawczych typu ITER, postawiła na mniejsze, modułowe reaktory pulsacyjne. Ich wiarygodność potwierdza nie tylko technologia, ale przede wszystkim pieniądz. Microsoft podpisał z Helionem wiążącą umowę na zakup energii elektrycznej, której dostawy mają ruszyć już w 2028 roku. To nie jest niezobowiązujący list intencyjny, lecz kontrakt z karami umownymi. Amerykanie zakładają, że w ciągu najbliższych dwudziestu lat to właśnie małe elektrownie termojądrowe będą stanowiły podstawę zasilania dla ich chmury obliczeniowej, uniezależniając infrastrukturę cyfrową od wahań na rynkach paliw kopalnych.

Warto również odnotować strategiczny ruch Sama Altmana, twórcy OpenAI. Zainwestował on w Helion Energy 375 milionów dolarów, co stanowi największą inwestycję w jego portfelu. Nie jest to filantropia, lecz chłodna kalkulacja: stworzenie Ogólnej Sztucznej Inteligencji (AGI) wymaga energii tak taniej i dostępnej, że jej koszt przestanie być istotnym czynnikiem w bilansie ekonomicznym. W niedalekiej przyszłości taki prąd pochodzący z tej fuzji ma być towarem tak powszechnym, że pozwoli na energochłonne procesy, które dziś są nieopłacalne - jak choćby masowe odsalanie wody morskiej czy syntetyczna produkcja paliw lotniczych z dwutlenku węgla wyłapanego z atmosfery.

Ziemia 2.0 i cyfrowe poligony

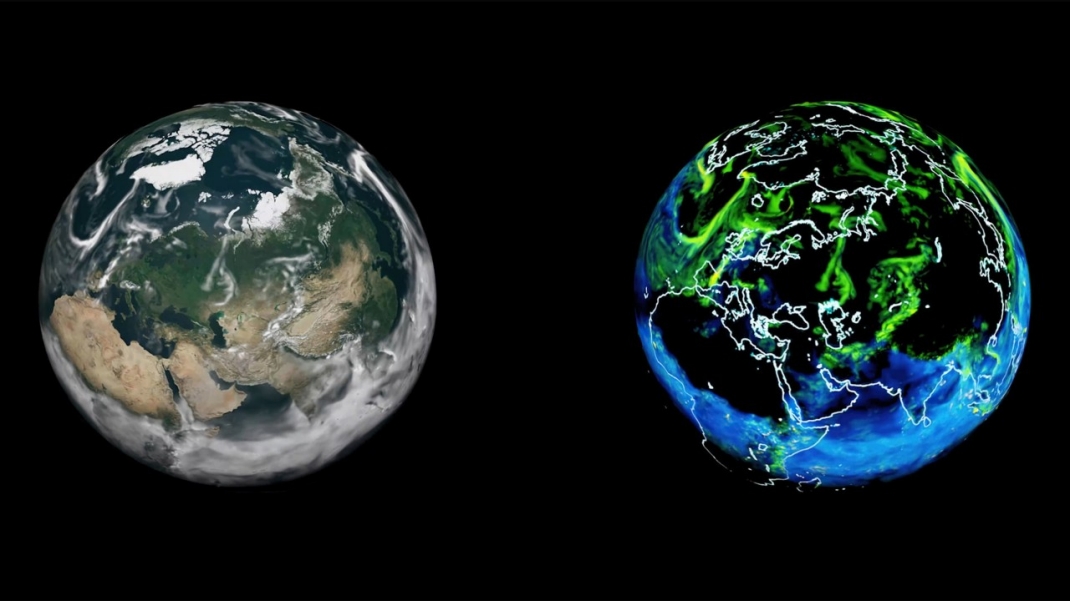

Musimy odczarować pojęcie, które w ostatnich latach zostało strywializowane przez media i popkulturę. Metawersum, w ujęciu inżynieryjnym, nie ma nic wspólnego z kreskówkowymi awatarami czy wirtualnymi spotkaniami towarzyskimi. Prawdziwa rewolucja odbywa się w sektorze przemysłowym pod nazwą "Cyfrowych Bliźniaków". To wirtualne, ale wierne fizycznie kopie obiektów rzeczywistych - od pojedynczej śruby, przez całą fabrykę BMW (co już funkcjonuje), aż po... całą planetę. W perspektywie nadchodzących lat, kluczowym narzędziem cywilizacyjnym nie będzie już tylko obserwacja Ziemi z satelitów, ale jej symulacja w czasie rzeczywistym.

Prym wiedzie tutaj NVIDIA ze swoim projektem Earth-2. Jensen Huang, dyrektor generalny firmy, postawił sprawę jasno: aby walczyć ze zmianami klimatu, musimy mieć możliwość ich precyzyjnego modelowania. Obecne modele meteorologiczne są zbyt wolne i mało dokładne, by przewidzieć lokalne skutki globalnych zmian z wyprzedzeniem dekad. Dlatego inżynierowie budują superkomputer Eos, dedykowany wyłącznie temu zadaniu. Wykorzystuje on model sztucznej inteligencji FourCastNet, który potrafi symulować zjawiska atmosferyczne dziesiątki tysięcy razy szybciej i z większą precyzją niż tradycyjne metody numeryczne.

Dlaczego to tak ważne dla naszej przyszłości? Ponieważ wchodzimy w erę, w której pasywna ochrona środowiska może okazać się niewystarczająca i konieczne staną się działania z zakresu geoinżynierii - na przykład rozpylanie aerozoli w stratosferze w celu odbicia promieni słonecznych czy masowe zalesianie konkretnych obszarów. W świecie rzeczywistym nie ma miejsca na metodę prób i błędów, gdyż pomyłka może doprowadzić do nieodwracalnej katastrofy ekologicznej. Earth-2 ma stać się globalnym poligonem doświadczalnym. Zanim inżynierowie podejmą decyzję o budowie gigantycznej tamy czy zmianie biegu rzeki, przeprowadzą tysiące symulacji w wirtualnym bliźniaku Ziemi, sprawdzając, jak ta ingerencja wpłynie na ekosystem za 10, 20 czy 50 lat.

Platforma Omniverse, na której budowane są te symulacje, to zapowiedź nowego standardu w nauce. Lada moment granica między "teoretyzowaniem", a "testowaniem" ulegnie zatarciu. Każdy większy projekt infrastrukturalny, każde nowe miasto i każda farma wiatrowa, zanim powstanie fizycznie, będzie musiała "przeżyć" swoje cyfrowe życie, udowadniając swoją efektywność energetyczną i neutralność środowiskową w symulacji o rozdzielczości pojedynczych metrów. Nadejdzie koniec ery zgadywania w polityce klimatycznej.

Człowiek, a więc interfejs ostateczny

Przez ostatnie pół wieku historia informatyki była historią walki z barierą wejścia. Od kart perforowanych, przez wiersz poleceń, aż po graficzne interfejsy i ekrany dotykowe - zawsze staraliśmy się skrócić dystans między ludzką myślą, a reakcją maszyny. Za dwadzieścia lat ten dystans ma zniknąć całkowicie. Smartfon, jako prostokątne urządzenie trzymane w dłoni, podzieli los pagera i faksu. Stanie się archaicznym reliktem epoki, w której musieliśmy pochylać głowy, by uzyskać dostęp do informacji. Nadchodząca rewolucja dotyczy przepustowości danych między biologicznym mózgiem, a krzemowym procesorem.

Na czele tej zmiany stoi Neuralink ze swoim programem PRIME. Choć obecne sukcesy firmy, takie jak implant Telepathy, skupiają się na przywracaniu sprawności osobom sparaliżowanym (pozwalając im choćby obsługiwać kursor na ekranie siłą woli), to cel długofalowy wykracza daleko poza medycynę naprawczą. Elon Musk definiuje go jako konieczność ewolucyjną: aby człowiek nie stał się intelektualnie bezużyteczny w świecie zdominowanym przez superinteligentne algorytmy, musi zwiększyć "szerokość pasma" komunikacyjnego. Mowa, a nawet pisanie, to metody stratne i powolne - przesyłamy zaledwie kilkadziesiąt bitów na sekundę. Bezpośredni interfejs neuronalny pozwoli na komunikację z szybkością myśli. Wizje przyszłości sugerują, że edukacja może przestać być żmudnym procesem zapamiętywania, a stanie się kwestią pobierania pakietów danych bezpośrednio do kory mózgowej. To brzmi trochę jak Cyberpunk czy Matrix, ale naukowcy faktycznie nad tym pracują.

Dla tych, których wizja chirurgicznej ingerencji w czaszkę napawa lękiem, alternatywę szykują laboratoria Reality Labs należące do Mety. Ich podejście opiera się na elektromiografii (EMG) i technologii rozwijanej w ramach projektu Orion. Zamiast wiercić w kości, inżynierowie odczytują sygnały elektryczne, które mózg wysyła do dłoni poprzez nerwy w nadgarstku.

Urządzenie noszone na ręku potrafi wykryć intencję ruchu ułamki sekund zanim poruszymy palcem. To pozwala na sterowanie rzeczywistością rozszerzoną w sposób niemal magiczny - bez machania rękami w powietrzu, wystarczą mikro-ruchy, a nawet samo skupienie na chęci wykonania akcji. W roku 2025 klawiatura i myszka będą eksponatami muzealnymi. Pisanie tekstu, projektowanie grafiki czy sterowanie domem będzie odbywać się płynnie, intuicyjnie i niemal niezauważalnie dla postronnego obserwatora. Technologia stanie się niewidzialna, usuwając się w cień, by po prostu działać jako przedłużenie naszej woli.

Logistyka międzyplanetarna

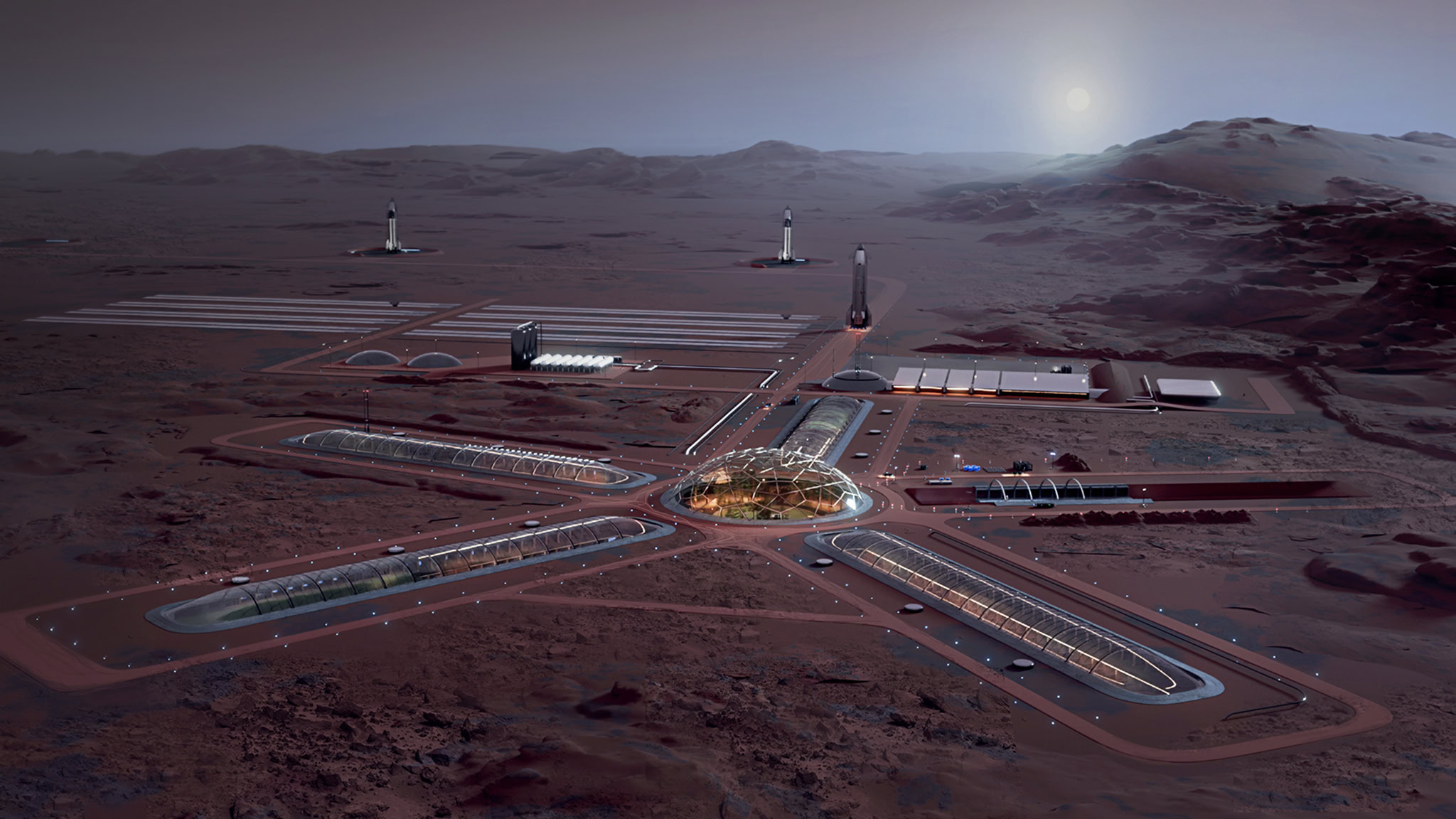

Gdy mówimy o kosmosie w perspektywie dwóch najbliższych dekad, musimy porzucić skojarzenia z programem Apollo. Tamte misje były aktami politycznej demonstracji siły - wbiciem flagi, zebraniem księżycowej gleby i szybkim powrotem na Ziemię. To, co dzieje się obecnie w bocznych dokach Teksasu, to przygotowanie do procesu przemysłowego na niespotykaną skalę. Celem nie jest turystyka, lecz stworzenie "kopii zapasowej" dla cywilizacji. W nomenklaturze inżynieryjnej nazywa się to redundancją danych - jeśli Ziemia ulegnie awarii (czy to w wyniku wojny, pandemii, czy uderzenia asteroidy), gatunek ludzki ma przetrwać w innej lokalizacji.

Kluczem do tego zamka nie jest sama technologia rakietowa, bo tę znamy od lat 60., lecz ekonomia transportu. Firma SpaceX, budując system nośny Starship, zmieniła fundamentalne równanie lotów kosmicznych. Do niedawna wyniesienie kilograma ładunku na orbitę kosztowało dziesiątki tysięcy dolarów, a rakiety były jednorazowe niczym plastikowe sztućce. Starship wprowadza technologię pozwalającą na odzyskanie obu stopni rakiety. To sprawia, że koszt transportu spada drastycznie, otwierając drogę do masowej migracji towarowej. Nie mówimy tu o kilku astronautach, ale o milionach ton sprzętu, paneli słonecznych, maszyn górniczych i generatorów tlenu niezbędnych do podtrzymania życia.

Harmonogram kolonizacji Marsa jest podyktowany mechaniką nieba, a konkretnie okresem synodycznym. Ziemia i Mars zbliżają się do siebie optymalnie co 26 miesięcy. To są wąskie "okna startowe", w których lot jest najkrótszy i najtańszy energetycznie. Plan na rok 2050 zakłada, że w każdym takim oknie z orbity okołoziemskiej wyruszać będzie nie jeden statek, lecz cała flotylla. Wizja Elona Muska, choć przez wielu traktowana sceptycznie co do terminów, jest matematycznie spójna: aby zbudować na Marsie samowystarczalne miasto, potrzeba około miliona mieszkańców i gigantycznego zaplecza przemysłowego.

Krytycznym elementem tej układanki, który musi zostać opanowany do perfekcji, jest produkcja paliwa na miejscu, czyli in situ (ISRU). Starship napędzany jest ciekłym metanem i tlenem. Oba te składniki można wytworzyć z marsjańskiej atmosfery (bogatej w dwutlenek węgla) oraz lodu wodnego ukrytego pod powierzchnią, wykorzystując tak zwaną reakcję Sabatiera. To właśnie ta chemiczna niezależność sprawi, że Czerwona Planeta przestanie być cmentarzyskiem lądowników, a stanie się stacją paliwową i bazą wypadową. Do połowy stulecia obecność człowieka na Marsie nie będzie już newsem w serwisach informacyjnych - będzie rutynową operacją logistyczną, równie ekscytującą co transport kontenerowy przez Pacyfik.

Wielka Konwergencja. Architektura roku 2050

Największym błędem w analizowaniu przyszłości jest traktowanie technologii jako odrębnych silosów. W rzeczywistości inżynierskiej wszystkie opisane wyżej domeny - kwantowa informatyka, fuzja jądrowa, sztuczna inteligencja i eksploracja kosmosu - nie będą funkcjonować obok siebie, lecz będą się wzajemnie przenikać i warunkować. Mamy do czynienia ze zjawiskiem konwergencji, czyli zbiegu technologii, który tworzy nową jakość, niemożliwą do osiągnięcia przez każdą z tych dziedzin z osobna.

Mechanizm ten zadziała jak precyzyjny układ naczyń połączonych. Bez taniej i nieograniczonej energii z reaktorów termojądrowych (Helion), utrzymanie energochłonnych superkomputerów kwantowych (IBM) i centrów danych przetwarzających symulację całej planety (NVIDIA) byłoby ekonomicznie niemożliwe. Z drugiej strony, to właśnie moc obliczeniowa komputerów kwantowych pozwoli na błyskawiczne projektowanie nowych, ultrawydajnych materiałów budowlanych i osłon radiacyjnych, które są niezbędne, by flota statków kosmicznych mogła bezpiecznie przewozić ludzi na Marsa. Sztuczna inteligencja z kolei, zasilana tą energią i mocą obliczeniową, będzie zarządzać skomplikowaną logistyką tych procesów w tempie nieosiągalnym dla ludzkich rąk.

W tym technologicznym ekosystemie człowiek przestaje być wąskim gardłem. Dzięki bezpośrednim interfejsom mózgowym (Neuralink) stajemy się integralną częścią cyfrowej pętli decyzyjnej. Nie będziemy tracić czasu na manualną obsługę maszyn; będziemy dyrygentami orkiestry algorytmów, definiując cele i kierunki rozwoju, podczas gdy systemy autonomiczne zajmą się ich realizacją. Rok 2050 nie przyniesie nam świata z filmów science fiction, w którym technologia jest magią. Przyniesie świat radykalnej optymalizacji, w którym problemy uchodzące dziś za nierozwiązywalne - od niedoboru energii po choroby neurodegeneracyjne - staną się zadaniami inżynieryjnymi z konkretnym terminem wykonania.

Przyszłość, którą właśnie zarysowałem, nie jest mglistą obietnicą. Jest logiczną konsekwencją decyzji inwestycyjnych podjętych w pierwszej połowie lat dwudziestych XXI wieku. Fundamenty pod rok 2050 zostały już wylane. To, co obserwujemy dzisiaj w raportach giełdowych i na poligonach doświadczalnych, to po prostu wznoszenie konstrukcji nośnej nowej cywilizacji. Powyższe dane oparte zostały o wiele źródeł i branżowych dokumentów, więc mam nadzieję, że dobrze Wam się to czytało. Dajcie znać w komentarzach co myślicie o nadchodzącej przyszłości. Do usłyszenia!

Przeczytaj również

Komentarze (3)

SORTUJ OD: Najnowszych / Najstarszych / Popularnych