Jakie są najciekawsze karty graficzne minionej epoki, które królowały w naszych domach?

W ostatnich latach zadebiutowało wiele kart graficznych, które z perspektywy "przeciętnego konsumenta" były kluczowe w kontekście grania czy przekraczania kolejnych granic. Zarówno po stronie NVIDIA, jak i ATI, a także późniejszego AMD chciałbym wskazać co najmniej kilka kart, o których kiedyś marzyliśmy i chcieliśmy za wszelką cenę zainstalować w naszych komputerach.

Zacznijmy więc od roku 2000 i przejdźmy przez kolejne 23 lata, aż do dzisiaj. Nie będą tutaj budować jakiegoś konkretnego rankingu pod względem opłacalności czy jakości. Skoncentrujemy się za to na wydajności, ale też i wpływie danego układu na ogólny rynek. Są w końcu karty, których moc nie jest szczególnie imponująca, ale dzięki znakomitemu współczynnikowi ceny do wydajności, znacząco wpłynęły na rozwój potęgi komputerów stacjonarnych. W tym materiale będziemy też omawiać wyłącznie jednostki desktopowe. Na mobilne być może przyjdzie czas nieco później.

W roku 2000 to właśnie NVIDIA dokonała prawdziwej rewolucji za sprawą GeForce 256

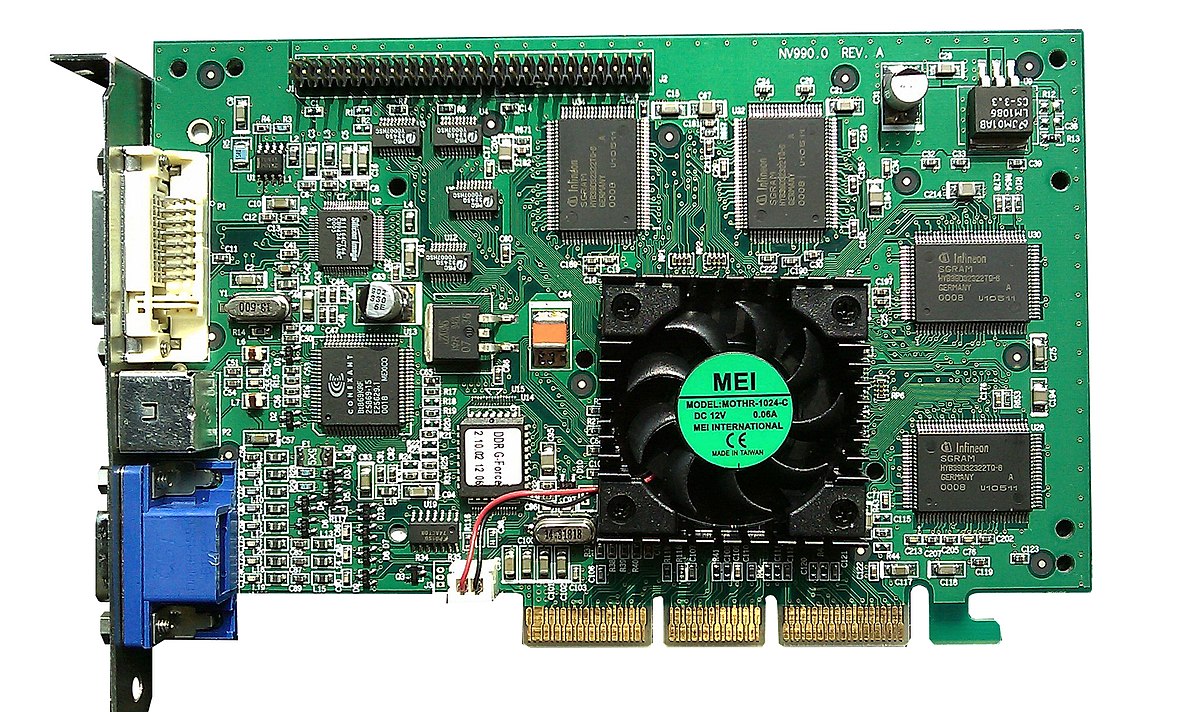

Trzeba przyznać, że GeForce 256 często jest określany mianem karty graficznej od której rozpoczęła się prawdziwa epoka generowania trójwymiarowej grafiki w grach (to także pierwsze GPU w historii, ponieważ zdolne było do samodzielnego generowania grafiki 3D). Wydany w grudniu 1999 roku układ zachwycał swoją niesamowitą, jak na tamte czasy, mocą i możliwościami. Karta kosztowała wówczas niewielkie pieniądze, oferując "aż" 32 MB pamięci RAM DDR (w grudniu, bo wcześniej w październiku sprzedawano modele z pamięcią SDR SDRAM) i taktowanie rdzenia na poziomie 150 MHz. Przeskok wydajności w grach względem popularnych pod koniec lat 90. akceleratorów 3D (jak Voodoo3 3500 od 3DFX czy NVIDIA RIVA TNT2 Ultra) wynosił średnio aż 50%. GeForce 256 to także pierwszy układ z pełnym wsparciem dla bibliotek Direct3D 7.0.

Na odpowiedź konkurencji nie trzeba było dużo czekać, a do gry weszła firma ATI, która zapoczątkowała nową serię układów graficznych znanych pod marką Radeon. Miały być odpowiedzią na GPU od NVIDIA - GeForce 256, stąd na Radeona R100 mówiono niekiedy potocznie "Radeon 256", by z czysto marketingowego punktu widzenia wyrównać dostępne możliwości. Był to układ wyposażony poczatkowo w 32, a następnie 64 MB pamięci RAM DDR, taktowanych z prędkością do 366 MHz (efektywnie). Karta wspierała też biblioteki DirectX 7.0 oraz OpenGL 1.3, a sprzedawane wtedy GPU zwane Radeon 7200 lub 7500 potrafiły zgarnąć nieco tortu z tego niezwykle chłonnego rynku. Niemniej, dalej czołowe karty graficzne wytwarzała wtedy NVIDIA, która dodatkowo zdominowała rynek prawowitym następcą, czyli modelem GeForce 2 GTS - pod koniec 2000 roku nie było szybszego GPU na rynku.

Modele z serii NVIDIA GeForce 3 wydane w lutym 2001 roku także wprowadzały szereg istotnych nowości. Jedną z nich było pełne wsparcie dla najnowszych bibliotek DirectX 8.0, ale też takich technik jak pixel i vertex shader. To dzięki nim mogliśmy przekraczać kolejne granice, generując znacznie ładniejszą grafikę w najnowszych grach komputerowych. GeForce 3 zadebiutował w kilku odmianach, z czego najszybsza, z dopiskiem "Ti" jest prekursorem dzisiejszych najszybszych modeli z tym rozszerzeniem w nazwie. Co jednak ciekawe, dalej układy GeForce 2 z serii Ultra miały o 25% szybsze taktowanie rdzenia od swoich młodszych braci, a czasem nawet wyprzedzały modele z serii GeForce 3 w syntetycznych benchmarkach, co nie spotkało się wtedy ze zbyt pozytywnym odbiorem. Nie zmienia to faktu, że NVIDIA dalej dominowała na rynku kart graficznych.

W Polsce wiele osób z całą pewnością posiadało w swoich domach model NVIDIA GeForce 4 MX. To karta wydana w 2002 roku, a MX był najsłabszą ale i najtańszą wersją, która stanowiła tzw. "entry-level" dla wydajnych komputerów gamingowych. To był próg wejścia, który często spotykał się z pozytywnym odbiorem, gdy myśleliśmy o zakupie wydajnego układu. Miał jednak swoje bolączki, w tym całkowity brak wsparcia dla programowalnych vertex i pixel shaderów z bibliotek DirectX 8.0. Nazwa "GeForce 4 MX" była więc dość myląca, bo karta często przegrywała starcie nawet z układami z poprzedniej serii - GeForce 3. Nie miała też niczego wspólnego z GPU z rozszerzeniem "Ti", ale stała się hitem sprzedażowym, kosztując zaledwie 30% więcej od GeForce 2 MX, czym zaskarbiła sobie bardzo liczne grono sympatyków.

W sierpniu 2002 roku zadebiutowały na rynku karty graficzne ATI Radeon z serii 9000, z czego najwydajniejszy był Radeon 9800 Pro (wydany w marcu 2003 roku), oferując pełne wsparcie dla bibliotek DirectX 9.0 i OpenGL 2.0, jednocześnie zjadając na śniadanie wszystkie układy z rodziny NVIDIA GeForce 4. To był też jeden z tych modeli, który znacznie wpłynął na układ sił na rynku, poważnie nadszarpując zaufanie, jakie NVIDIA zbudowała sobie lata wcześniej. To był także przykład tego, jak dobrze jest mieć na rynku konkurencję. ATI nie próżnowało i dalej skutecznie rozwijało swoje produkty i chociaż "zieloni" wprowadzili na rynek karty z rodziny GTX 6000, to nie mogły się one równać z technologiami zaproponowanymi przez "czerwonych". Zunifikowane potoki shaderów, które mogliśmy też znaleźć w konsolach Xbox 360, pozwalały układom z serii Radeon X1900 i X1950 zademonstrować absolutnie rewelacyjne wyniki wydajności w grach komputerowych. W tamtym czasie, gdy w swoim komputerze korzystałem z karty Radeon X1950 Pro, żaden tytuł nie stanowił wyzwania.

Prawdziwa rewolucja nastąpiła w momencie wydania karty NVIDIA GeForce 8800 GTX

Dominacja ATI na polu wydajności nie trwała jednak długo, bo NVIDIA już rok później zaprezentowała niesamowite GPU, królujące na rynku przez blisko 2 lata. GeForce 8800 GTX, a także nieco słabszy 8800 GT to były karty, które całkowicie zdominowały rynek swoją topową wydajnością. Gdy w 2007 roku zadebiutował Crysis, to właśnie 8800 GTX pozwalało na swobodną, niczym nieskrępowaną rozgrywkę (jeśli mówimy o 30-40 klatkach w wysokich rozdzielczościach na max. detalach, co wtedy było wartością wystarczającą), a wszystko za sprawą aż 768 MB pamięci RAM i pełnym wsparciu dla DirectX 10. Wtedy ATI odpadło w przedbiegach i nie potrafiło przez dłuższy czas zaproponować jakiejkolwiek wartościowej konkurencji, aż do 2008 roku, gdy wydano układ z dwoma rdzeniami zwany Radeonem 3870 X2.

Hegemonia NVIDIA zdążyła jednak zakorzenić się wśród umysłów użytkowników tak mocno, że śmiało można powiedzieć, że GPU z serii GTX 8000 wyniosły te firmę do miejsca w którym znajduje się obecnie. Seria 9000 nie była aż tak imponująca, za to po stronie ATI mogliśmy w 2008 roku kupić układ zwany Radeonem 4870, kosztującym wtedy "zaledwie" 299$. Jego wydajność dorównywała modelowi 8800 GT, ale przy niższym poborze mocy, a także niższych temperaturach rdzenia i lepszej kulturze pracy. Pamiętam, że wtedy też w swoim komputerze przeskoczyłem z układu 7800 GT właśnie na Radeona 4870 i byłem niesamowicie zadowolony, ale i z drobną zazdrością patrzyłem na sprzęt najbliższego kumpla, gdzie dumnie "siedział" 8800 GTX. Niemniej, ATI miało wtedy spore problemy ze sterownikami (głównie z ich stabilnością), które przegrywały z propozycją i wsparciem od NVIDIA.

Do kolejnego przełomu musieliśmy poczekać następne kilka lat, aż do 2012 roku, gdy NVIDIA wprowadziła na rynek serię GTX 600, a szczególnie układ GTX 660, z którego swoją drogą zrobiłem kiedyś SLI, by mieć wydajność porównywalną/wyższą od GTX 680. To właśnie ta całkiem niedroga karta, GTX 660, zdominowała komputery "przeciętnych" graczy i zapoczątkowała kultywowaną do dziś erę kupowania układów ze średniej półki, które swoimi możliwościami są w pełni wystarczające dla rozdzielczości 1080p. Kolejny przystanek, to była seria GTX 1000, czyli Pascale, gdzie model GTX 1080 Ti do dziś jest chętnie kupowany przez miłośników wirtualnej rozgrywki, a karta w dniu premiery (w marcu 2017 roku) dosłownie powalała swoimi niesamowitymi możliwościami i aż 11GB wbudowanej pamięci RAM. Pamiętam, że to właśnie na tym układzie po raz pierwszy posmakowałem rozdzielczości 4K na dużym, 32" monitorze, gdzie w Battlefield 1 osiągałem średnio 80-90 klatek na sekundę na najwyższych detalach. Co też warte wspomnienia, to z tej serii pochodzi układ GTX 1060, który jeszcze do niedawna był czołowym GPU znajdującym się w komputerach gamingowych, zgodnie ze statystykami Steam (przez kilka lat zajmował pierwszą pozycję). Dopiero całkiem niedawno to miejsce przejął RTX 3060.

Ostatnią, dość dużą rewolucją, było pojawienie się serii RTX 20 (szczególnie układu RTX 2080 w 2018 roku), która wprowadziła pod nasze strzechy zaawansowany ray-tracing, dość znacząco wpływając na rozwój grafiki w grach komputerowych. Była to także pierwsza karta wdrażająca obsługę techniki skalowania obrazu bazując na algorytmach sztucznej inteligencji, czyli DLSS, wykorzystywany z dużymi sukcesami do dzisiaj. To o tyle istotna technologia, że została w jakiejś formie zaimplementowana także przez AMD czy Intela za sprawą odpowiednio FSR oraz XeSS (chociaż bazując na nieco innych rozwiązaniach technicznych). To właśnie NVIDIA, patrząc przekrojowo, wprowadziła na rynek najwięcej produktów wartych uwagi, ale nie bylibyśmy świadkami tego wszystkiego, gdyby nie konkurencja. Najpierw ATI, a potem AMD dzielnie walczą, by proponować równie niesamowite i intrygujące rozwiązania. Do dziś karty z tego "obozu" mają swoich wielkich zwolenników i całe szczęście, że firma dalej radzi sobie tak dobrze. Nie ma dla konsumentów niczego lepszego od możliwości wyboru.

Przeczytaj również

Komentarze (72)

SORTUJ OD: Najnowszych / Najstarszych / Popularnych