Czy wykorzystanie DLSS 3 w jakikolwiek sposób wpływa na słabsze procesory? Sprawdźmy bottleneck i opóźnienia

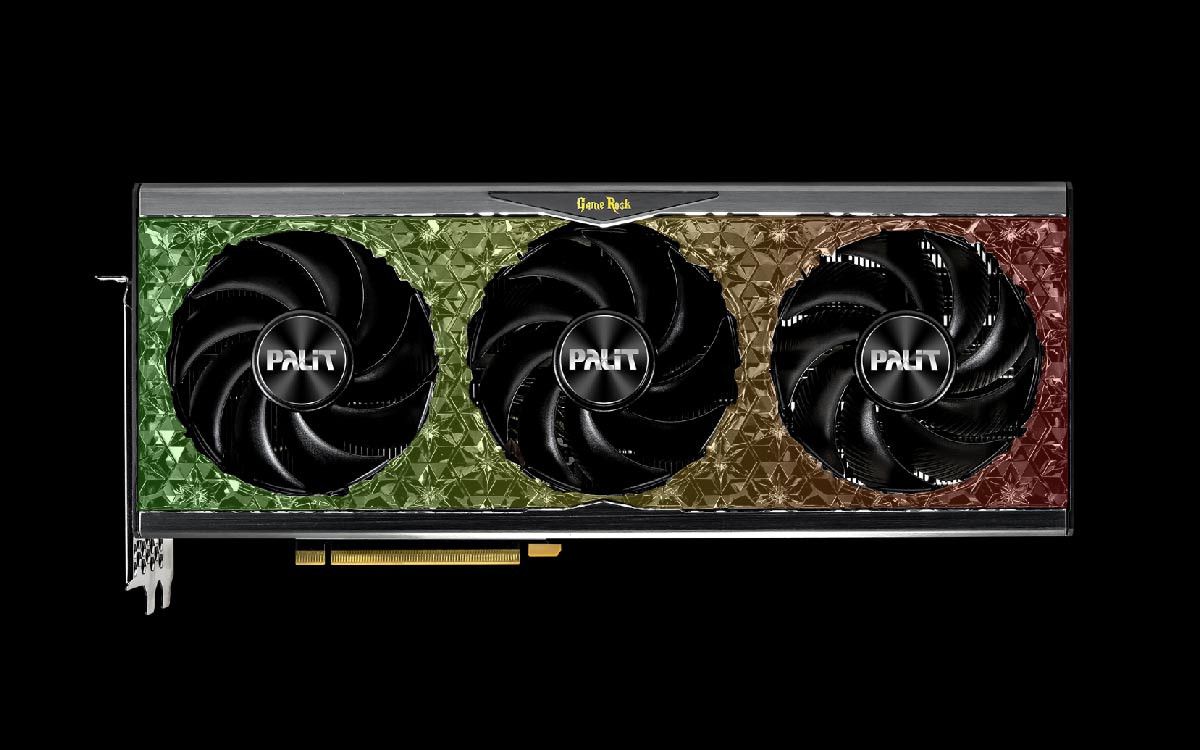

Jakiś czas temu do naszej redakcji przyjechała karta graficzna PALIT GeForce RTX 4080 w edycji GameRock OC. Ponieważ w moim prywatnym komputerze dysponuje całkiem świeżą jednostką i5-12600K, postanowiłem sprawdzić, czy tak mocne GPU będzie mieć jakikolwiek wpływ na działanie tego procesora w grach. Czy doprowadzę do tzw. bottlenecku, czyli ograniczenia wydajności karty graficznej przez CPU? Sprawdźmy to.

Materiał powstał przy współpracy z firmą Palit.

Zakładam, że wielu z Was, podobnie do mnie, dysponuje w komputerach procesorami starszych generacji lub ze średniej półki. Jest to absolutnie normalne i zrozumiałe, bowiem nie zawsze chcemy czy potrzebujemy kupować absolutnie topowe podzespoły. Przychodzi jednak moment w którym nasz procesor jeszcze daje radę, ale GPU już powoli przestaje dobrze wypadać w najnowszych grach komputerowych. Pierwsze co wpada nam do głowy, to nie wymiana całego komputera, a właśnie karty graficznej, bo przecież to ona w dużej mierze odpowiada za liczbę klatek. To wszystko prawda, natomiast w przeszłości często zdarzało się, że GPU miało istotny wpływ na działanie CPU i szczególnie w niskich rozdzielczościach procesor "dławił" kartę, nie pozwalając jej wskoczyć na pełne obroty. Jeśli będziemy grać w rozdzielczości 2560x1440p lub 4K, to tego problemu raczej nie będzie. Powinien on także całkowicie zniknąć przy wykorzystaniu techniki NVIDIA DLSS. Postanowiłem sprawdzić, czy faktycznie tak jest.

Przy założeniu, że wykorzystujemy najnowszą kartę graficzną GeForce RTX 4080 i DLSS 3, czy procesor ma wpływ na działanie GPU?

Testy procesorów w grach zwykle wykonujemy w rozdzielczości 1080p. To daje nam gwarancje zauważalnie mniejszego narzutu na GPU, niż w przypadku wyższych rozdzielczości, a co za tym idzie, pozwoli na zaprezentowanie bardziej rzetelnych wyników wydajności samego CPU. Warto też pamiętać, że w określonych tytułach znajdują się lokacje typowo "procesorowe" i graficzne. Tam, gdzie znajduje się duża liczba obiektów na ekranie, tam zazwyczaj do akcji wkracza procesor. Im szybszy, tym lepiej, bo tym sprawniej stworzy całą siatkę wierzchołków gotowych do obróbki dla karty graficznej. Co jednak w sytuacji, gdy włączymy jedną z metod skalowania obrazu, czyli wspomniane wcześniej Deep Learning Super Sampling i to w trzeciej wersji? Do działania wykorzystuje rdzenie Tensor, a także akcelerację sprzętową "Optical Flow" dostępną wyłącznie na urządzeniach z rodziny GeForce RTX 40. To pozwala w znacznym stopniu zwiększyć liczbę klatek, ale także odciążyć CPU.

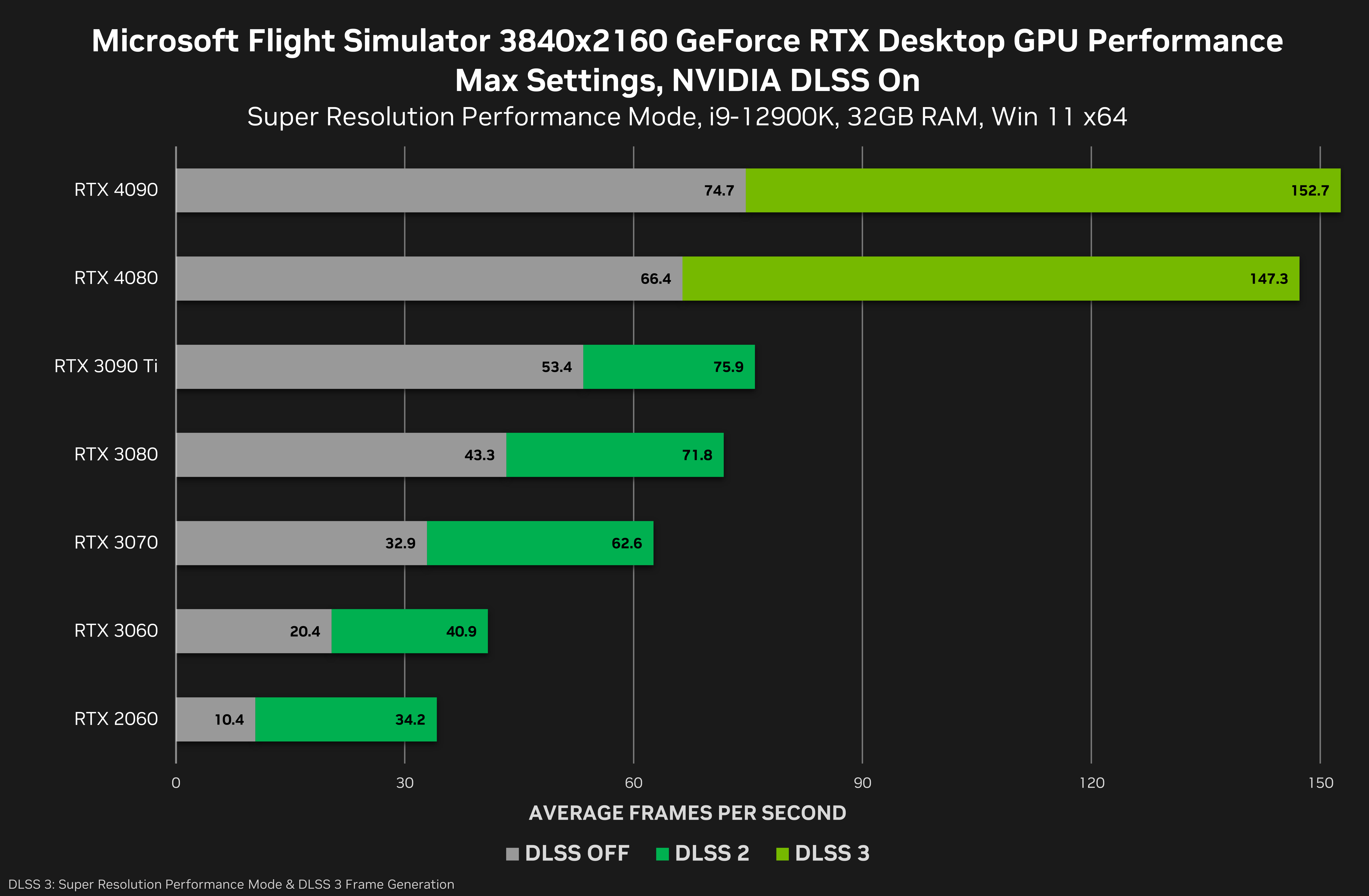

Wszystko właśnie za sprawą techniki generatora ramek. Dobrze ilustruje to przykład gry Microsoft Flight Simulator, która do tej pory była niesamowicie wymagająca dla dowolnego CPU na świecie. Przy zastosowaniu techniki Optical Multi Frame Generator DLSS 3 podwaja liczbę wyświetlanych ramek, gwarantując dwukrotny wzrost liczby klatek na sekundę, a dodatkowe ramki w żadnym wypadku nie są obsługiwane przez procesor. Ten jakby w ogóle ich nie widzi. Daje nam to gwarancje znacznych wzrostów wydajności, bo przecież same karty graficzne są od CPU o wiele potężniejsze i gwarantują znacznie większe możliwości obliczeniowe. Sam przyrost klatek w MFS z wykorzystaniem DLSS 3 i kart z rodziny GeForce RTX 40 jest doprawdy imponujący, co znakomicie ilustruje poniższy wykres. Czy widać przy tym jakieś różnice w jakości wyświetlanej grafiki? Trudno je zauważyć nawet w przypadku statycznego obrazka (gdy rozdzielczością wyjściową jest 4K), a co dopiero w ruchu. Co jednak równie istotne, zastosowanie DLSS 3 nie wpływa na wzrost tzw. "frametime" co sprawia, że nie odczujemy większych opóźnień przy jednocześnie zwiększonej płynności. Jest dokładnie odwrotnie - gra działa szybciej i jest bardziej responsywna (zyskując ze wzrostem liczby klatek).

NVIDIA już wcześniej deklarowała, że właśnie DLSS 3 dzięki generatorowi ramek skutecznie odciąży procesor przy obliczeniach związanych z grami. Sprawdziłem w akcji zarówno i5-12600K, i7-12700K oraz i9-13900K. Różnice w samej wydajności w grach (co ważne) przy zastosowaniu DLSS wynikały głównie z wyższego taktowania rdzenia i zwiększonej liczby pamięci cache trzeciego poziomu (i było to raptem kilka procent). Co podkreślam, nie miały żadnego przełożenia na wydajność Palit GeForce RTX 4080 z edycji GameRock OC. W dowolnej grze, gdzie mogłem wykorzystać DLSS 3 w trybie jakości, często osiągałem ponad 80 klatek na sekundę w rozdzielczości 4K przy maksymalnych detalach graficznych i z włączonym ray-tracingiem (jak choćby w Hogwarts Legacy). Nie patrząc na procentowe i szczegółowe analizy wykorzystania procesora i GPU w określonych momentach (bo jesteśmy portalem gamingowym i chodzi tu przede wszystkim o odczuwanie komfortu z grania) przyznam, że moja i5 świetnie sobie radzi w zestawieniu z RTX 4080. Mimo wszystko to nadal bardzo świeży procesor z 10 rdzeniami i 16 wątkami, którego taktowanie podkręciłem do 5,1 GHz. Na ten moment, patrząc także na wyniki testów dostępnych w sieci, różnice w rozdzielczościach 1440p czy 4K przy wykorzystaniu procesorów z ostatnich 4, a nawet 5 generacji wynoszą zaledwie kilka procent, gdy zestawimy je z najnowszymi kartami od NVIDIA, a większych różnic możecie upatrywać w zastosowanych technologiach bezpośrednio wewnątrz CPU. Nic też nie stoi na przeszkodzie, by wykorzystać najnowsze procesory od AMD, bo one również świetnie poradzą sobie z kartami "zielonych".

Przeczytaj również

Komentarze (35)

SORTUJ OD: Najnowszych / Najstarszych / Popularnych