Jak będzie wyglądał rynek części komputerowych w 2026 roku? Wszystkie dane, analizy i fakty, które warto znać

Patrząc na cenniki największych dystrybutorów elektroniki, musimy definitywnie porzucić nadzieję na powrót do normalności znanej z początku dekady. Mit taniego komputera do gier, który za trzy lub cztery tysiące złotych pozwalał na komfortową zabawę w wysokich detalach, został ostatecznie pogrzebany. Nie mamy do czynienia z tymczasową fluktuacją kursów walut czy przejściowym zatorem w Kanale Sueskim. To, co obserwujemy, to trwała zmiana paradygmatu, wynikająca z brutalnej, korporacyjnej kalkulacji. Gracz indywidualny, który przez lata był motorem napędowym postępu w dziedzinie układów graficznych, został zepchnięty na margines. W nowej hierarchii staliśmy się klientem odpadowym - odbiorcą technologii, która "spadnie ze stołu" gigantów zajmujących się sztuczną inteligencją.

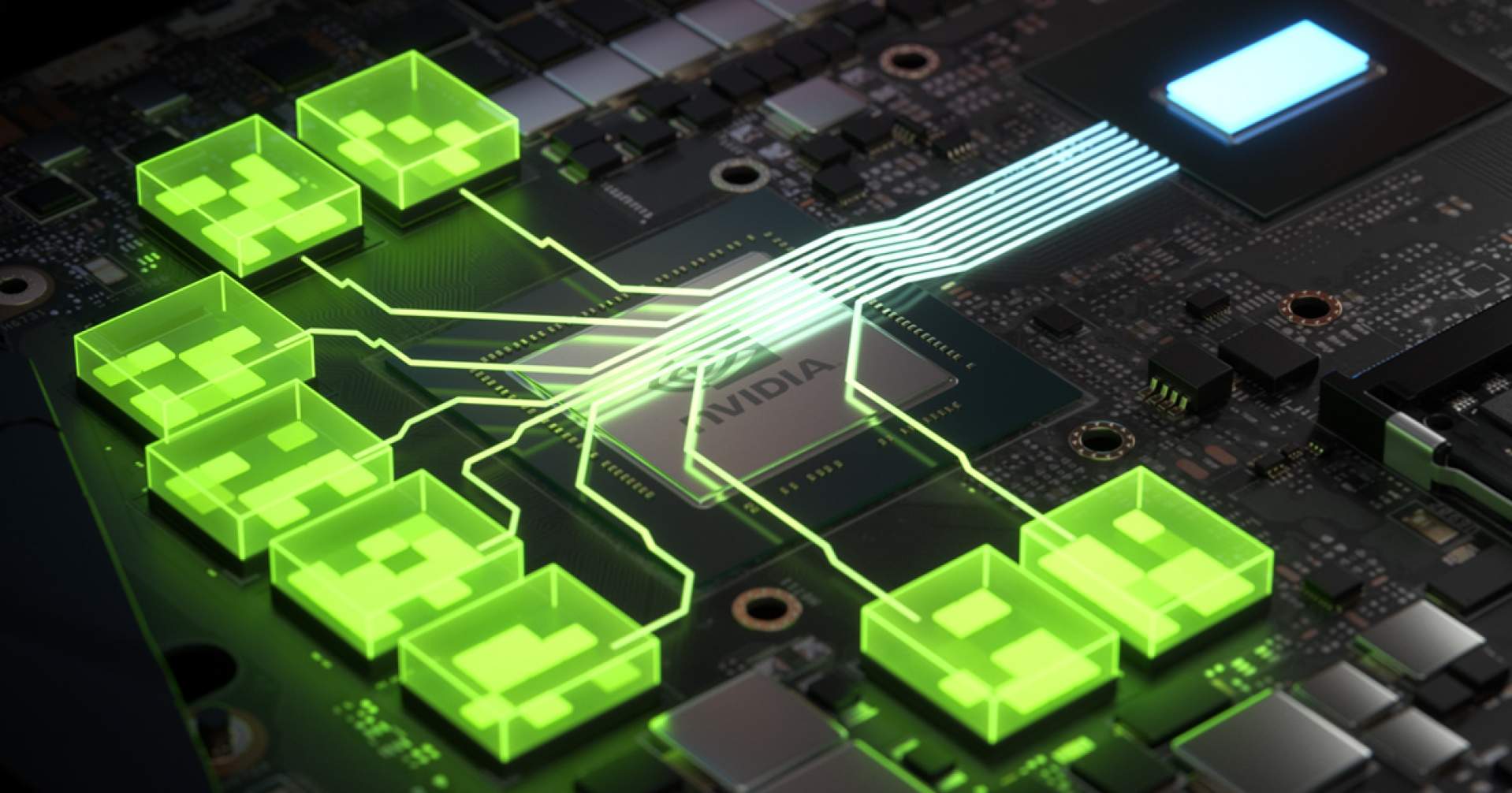

Aby zrozumieć skalę problemu, należy spojrzeć na wąskie gardło całej branży, czyli tajwańskie zakłady TSMC. To tam, przy liniach produkcyjnych obsługujących procesy 2 nm i 3 nm, decyduje się o dostępności sprzętu. Niemal siedemdziesiąt procent mocy przerobowych w najbardziej zaawansowanych litografiach zostało wykupione z dwuletnim wyprzedzeniem pod produkcję akceleratorów AI dla centrów danych - następców architektury Blackwell. Dla firm takich jak NVIDIA czy AMD rachunek ekonomiczny jest bezlitosny. Pojedynczy wafel krzemowy, przeznaczony na rynek serwerowy i obudowany w zaawansowaną integrację CoWoS, generuje przychód rzędu trzystu tysięcy dolarów. Ten sam wafel, pocięty na rdzenie do konsumenckich kart graficznych GeForce czy Radeon, przyniósłby zaledwie ułamek tej kwoty. W efekcie korporacje świadomie dławią podaż kart dla graczy, traktując ten segment jako zło konieczne, służące jedynie utylizacji krzemu, który nie spełnił rygorystycznych norm jakościowych dla serwerów.

Drugim gwoździem do trumny taniego sprzętu jest bariera fizyki, a konkretnie koszt wejścia w erę angstremową. Prawo Moore’a, które przez dekady gwarantowało nam coraz tańszą moc obliczeniową, przekształciło się w Prawo Cennika. Kluczowym winowajcą są tu systemy litograficzne High-NA EUV dostarczane przez holenderski holding ASML. Cena jednej takiej maszyny zbliżyła się do poziomu czterystu milionów dolarów, co stanowi blisko dwukrotny wzrost względem maszyn poprzedniej generacji. Amortyzacja tak gigantycznych inwestycji została w stu procentach przerzucona na klienta końcowego. To właśnie ten czynnik doprowadzi ostatecznie do śmierci segmentu budżetowego. Produkcja małych, tanich rdzeni graficznych - duchowych następców serii GTX 1650 czy RTX 3050 - stanie się ekonomicznie nieopłacalna. Koszt obróbki wafla w najnowszym procesie jest stały i astronomiczny, niezależnie od tego, czy wycinamy z niego potężne układy, czy małe czipy. W rezultacie producenci całkowicie porzucą rynek kart graficznych poniżej dwóch tysięcy złotych, ponieważ marża na nich nie pokrywa nawet kosztów operacyjnych uruchomienia maszyn.

Szok podażowy i śmierć tanich danych. Ofiary wojny o HBM

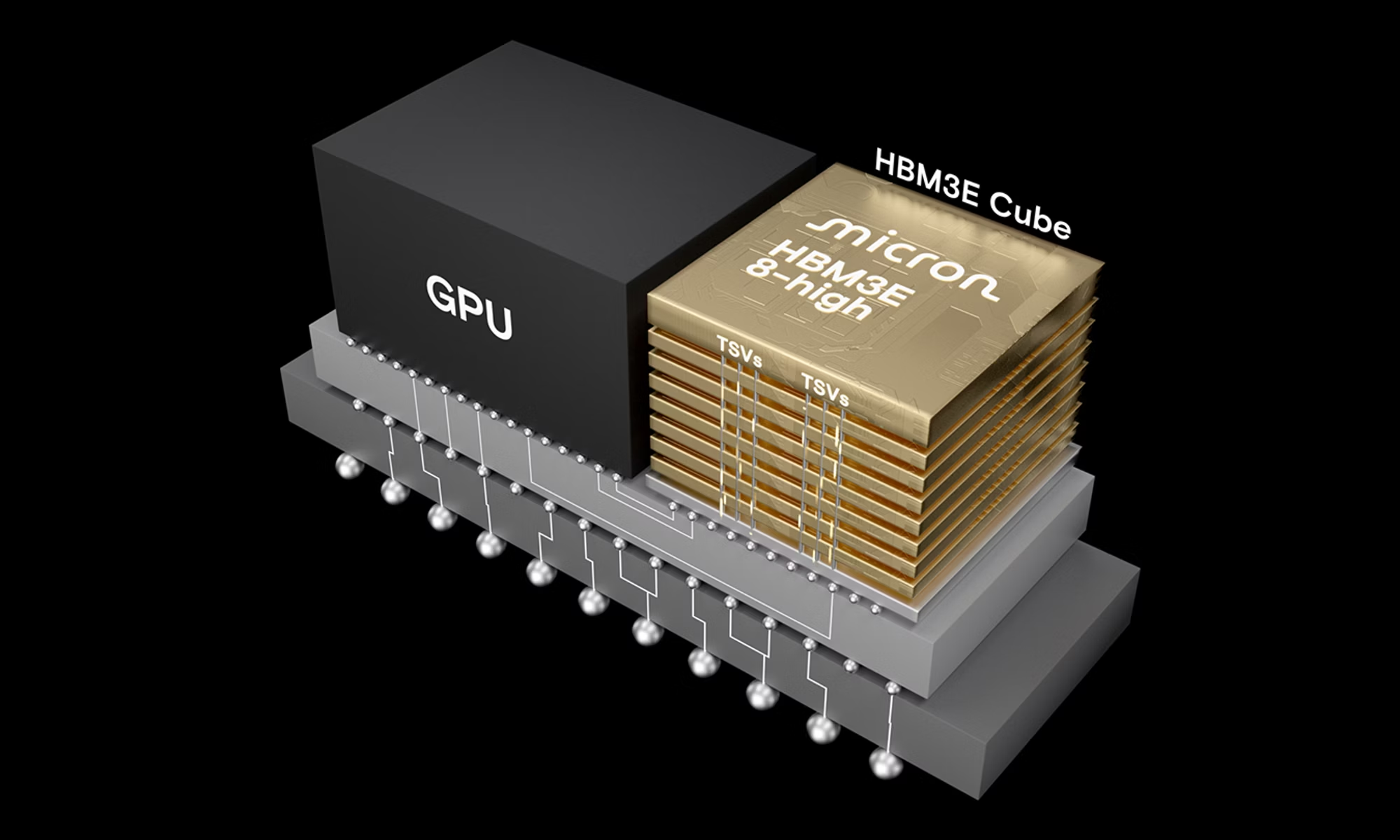

Jeśli sytuacja na rynku procesorów jest trudna, to na rynku pamięci mamy do czynienia z katastrofą, którą analitycy branżowi określają mianem "Szoku Microna". Punktem zwrotnym okazała się decyzja strategiczna ogłoszona przez zarząd amerykańskiego giganta - Micron Technology - pod koniec zeszłego roku. Firma, znana konsumentom głównie dzięki popularnej marce Crucial, oficjalnie zrewidowała swój model biznesowy, drastycznie ograniczając udział w rynku detalicznym. Kalkulacja była chłodna i czysto matematyczna: w obliczu nienasyconego popytu ze strony sektora Enterprise, walka o klienta indywidualnego, kupującego dyski SSD czy kości RAM na niskiej marży, stała się balastem finansowym. Moce przerobowe, które wcześniej służyły do produkcji tanich nośników danych dla graczy, zostały niemal w całości przekierowane na produkcję pamięci serwerowych oraz układów HBM, niezbędnych do funkcjonowania systemów sztucznej inteligencji.

Ruch ten wywołał efekt domina, wciągając w spiralę niedoborów pozostałych graczy z "Wielkiej Trójki", czyli południowokoreańskie koncerny SK Hynix oraz Samsung Electronics. W szczególności SK Hynix, będący głównym partnerem technologicznym NVIDIA, znalazł się w sytuacji, w której jego księgi zamówień na ten rok zostały wypełnione w ponad dziewięćdziesięciu procentach kontraktami dla dostawców chmury obliczeniowej. Choć firma oficjalnie nie wycofała się z rynku konsumenckiego, w praktyce jej produkty stały się towarem deficytowym, dostępnym "na papierze", ale nie na półkach sklepowych. Mamy tu do czynienia z klasycznym mechanizmem wypierania: każda linia produkcyjna przestawiona na wytwarzanie skomplikowanych, wielowarstwowych stosów HBM3E lub HBM4 oznacza fizyczne zmniejszenie podaży standardowych kości DRAM i pamięci NAND Flash.

Proces ten jest nieodwracalny ze względów technologicznych. Produkcja pamięci HBM jest znacznie bardziej zasobożerna i obarczona wyższym ryzykiem błędu niż produkcja standardowych kości DDR. Wymaga ona stosowania zaawansowanych technik integrowania, co drastycznie wydłuża czas cyklu produkcyjnego. W efekcie globalna podaż pamięci dla komputerów osobistych skurczyła się o blisko czterdzieści procent w skali roku, przy jednoczesnym wzroście popytu. Skutki cenowe są porażające. Dyski SSD o pojemności 2 TB, które jeszcze w 2023 roku aspirowały do miana rynkowego standardu, w 2026 roku ponownie staną się dobrem luksusowym, a ich ceny wzrosły średnio o dwieście procent rok do roku.

Konsekwencją tej wojny o zasoby jest degradacja standardów w gotowych zestawach komputerowych i laptopach. Aby utrzymać ceny na akceptowalnym poziomie, producenci OEM masowo powrócą do montowania nośników o pojemności 512 GB lub 1 TB, co w dobie gier zajmujących po 200 GB jest rozwiązaniem archaicznym. Rynek pamięci cofnie się w rozwoju o kilka lat - to, co było tanie i powszechne, zostanie zmonetyzowane przez branżę AI, zostawiając konsumenta z drogim sprzętem o mniejszych możliwościach.

Stratyfikacja absolutna. Koniec klasy średniej i nowa definicja luksusu

Konsekwencją opisanych zjawisk makroekonomicznych i technologicznych jest całkowite przeobrażenie struktury rynku PC, którą znaliśmy przez ostatnie dwie dekady. Koniec poprzedniego roku i w zasadzie początek 2026 przynoszą kres istnienia tak zwanej komputerowej klasy średniej - segmentu sprzętu, który oferowałby solidną wydajność za rozsądną cenę. W miejsce płynnego spektrum cenowego weszła ostra, binarna polaryzacja. Rynek podzielił się na dwa odizolowane od siebie światy: hermetyczną strefę ultra-premium oraz strefę terminali dostępowych.

Pierwszy z tych światów to domena entuzjastów i profesjonalistów, dla których komputer stał się narzędziem inwestycyjnym, a nie tylko zabawką. Próg wejścia do tej grupy drastycznie wzrósł. Złożenie kompletnej jednostki centralnej, która nie dławiłaby się w nowoczesnych tytułach i oferowała wydajność adekwatną do wysokich standardów – a więc rozdzielczość 4K czy path-tracing, wiąże się dziś z wydatkiem przekraczającym piętnaście tysięcy złotych. Mówimy tu o maszynach wyposażonych w karty graficzne z wyższej półki, szybkie pamięci DDR5 oraz zasilacze o mocy przekraczającej kilowat, niezbędne do obsłużenia prądożernych układów. Posiadanie tak skonfigurowanego komputera stało się wyznacznikiem statusu majątkowego, porównywalnym z posiadaniem audiofilskiego zestawu nagłośnieniowego czy profesjonalnego sprzętu fotograficznego. To właśnie jest tytułowa krzemowa arystokracja – wąska grupa konsumentów, którą stać na bezpośrednie konkurowanie o zasoby z sektorem biznesowym.

Dla całej reszty graczy, którzy zostali wypchnięci z rynku sprzętowego przez bariery cenowe, jedyną racjonalną alternatywą stała się migracja do chmury oraz ekosystemów zamkniętych. Usługi takie jak GeForce NOW czy Xbox Cloud Gaming przestały być jedynie technologiczną ciekawostką, a stały się głównym sposobem konsumpcji treści dla milionów użytkowników, których nie stać na kartę graficzną w cenie używanego samochodu. Komputer osobisty w domach wielu Polaków zredukował się do roli "cienkiego klienta" - prostego terminala służącego jedynie do odbierania strumienia wideo z serwerowni.

Teoretycznie, w obliczu astronomicznych cen podzespołów komputerowych, rynek konsol stacjonarnych powinien przeżywać swój złoty wiek, stając się naturalną szalupą ratunkową dla wypchniętych z rynku graczy. Rzeczywistość pokazuje jednak obraz stagnacji, który całkowicie przeczy tym podręcznikowym założeniom. Zamiast renesansu, obserwujemy bolesną weryfikację potencjału tego segmentu. Najbardziej dramatyczna sytuacja dotyczy obozu Microsoftu. Sprzedaż konsol Xbox Series w 2025 roku osiągnęła historyczne minima, w Europie spadając do poziomu błędu statystycznego. Microsoft de facto wywiesił białą flagę w wojnie na pudełka, drastycznie ograniczając obecność sprzętu na półkach sklepowych i finalizując swoją transformację w multiplatformowego wydawcę, dla którego własna konsola stała się opcjonalnym dodatkiem do abonamentu.

Sytuacja nie wygląda wcale różowo w obozie lidera. PlayStation, mimo braku realnej konkurencji i posiadania pozycji monopolisty, zamiast wzrostów notuje wyraźne spadki dynamiki sprzedaży. Rynek entuzjastów nasycił się szybciej, niż przewidywano, a brak presji ze strony rywala sprawił, że Sony popadło w inercję, utrzymując wysokie ceny sprzętu pięć lat po premierze. Model Pro, wyceniony na poziomie dobrej klasy PC sprzed lat, pozostał ciekawostką dla elit. Okazuje się, że gracze, nie mogąc pozwolić sobie na drogi komputer, wcale nie biegną masowo po konsolę, która również stała się drogą inwestycją. Zamiast tego, albo pozostają przy starszych generacjach sprzętu (PS4 wciąż żyje), grając w darmowe tytuły usługi jak Fortnite czy Roblox, albo całkowicie rezygnują z dedykowanych urządzeń. Mit konsoli jako "taniego azylu" upadł, ponieważ próg wejścia w gaming AAA - niezależnie od platformy - stał się barierą nie do przeskoczenia dla przeciętnego portfela.

Podatek od fizyki i pułapka "AI PC". Jak oprogramowanie uśmierca hardware

Analizując koszyk zakupowy nie sposób pominąć zjawiska, które branżowi eksperci nazywają "podatkiem od infrastruktury". Dotyczy on drastycznego wzrostu cen komponentów bazowych: płyt głównych i zasilaczy. Jeszcze dekadę temu płyta główna była elementem pasywnym cenowo - świadomy konsument mógł wybrać solidny model ze średniej półki za czterysta czy pięćset złotych, nie tracąc nic z wydajności. Dziś ten segment cenowy w zasadzie przestał istnieć, a winę za to ponosi nieubłagana fizyka transmisji danych. Standardy takie jak PCIe 5.0 (zadomowione w high-endzie) czy wchodzące do użytku rozwiązania gotowe na PCIe 6.0, a także obsługa pamięci DDR5 o taktowaniach przekraczających 8000 MT/s, wymusiły na producentach stosowanie technologii do niedawna rezerwowanych dla serwerowni.

Aby zapewnić integralność sygnału przy tak gigantycznych częstotliwościach i uniknąć zakłóceń elektromagnetycznych, producenci tacy jak ASUS, MSI czy Gigabyte musieli przejść na wielowarstwowe laminaty (8-10 warstw PCB klasy serwerowej) oraz stosować kosztowne retimery sygnału. Do tego dochodzą rozbudowane sekcje zasilania (VRM), które muszą być gotowe na dostarczenie nawet trzystu watów stabilnej mocy do procesora w chwilowych stanach obciążenia. W rezultacie, definicja "taniej i bezpiecznej" płyty głównej uległa przesunięciu. Konstrukcja, która gwarantuje stabilność i nie ulegnie termicznej degradacji po roku, to dziś wydatek rzędu półtora tysiąca złotych. Wszystko poniżej tej kwoty jest loterią fantową.

Równolegle jesteśmy świadkami wprowadzania na rynek jednego z najbardziej agresywnych mechanizmów inżynierii popytu w historii IT: standardu "AI PC". Dzisiaj definicja nowoczesnego komputera została sztucznie zawężona przez sojusz Microsoftu i producentów krzemu. Aby w pełni korzystać z ekosystemu Windows (w tym funkcji głębokiej integracji Copilota czy lokalnego przetwarzania danych wrażliwych), sprzęt musi posiadać dedykowany układ NPU o wydajności przekraczającej czterdzieści bilionów operacji na sekundę (40+ TOPS).

Prowadzi to do paradoksalnej i cynicznej sytuacji, w której potężne stacje robocze sprzed zaledwie trzech lat - wyposażone w topowe procesory Core i9 dwunastej/trzynastej generacji lub Ryzeny serii 5000/7000 - są przez system operacyjny i oprogramowanie klasyfikowane jako funkcjonalnie przestarzałe. Mimo że ich surowa moc obliczeniowa (FP32) jest wciąż gigantyczna i wystarczająca do każdego zadania, brak dedykowanego akceleratora neuronowego staje się pretekstem do programowego wykluczenia. Użytkownik takiego sprzętu staje się cyfrowym obywatelem drugiej kategorii, pozbawionym dostępu do nowych funkcji systemu nie z powodu braku mocy, lecz z powodu braku "certyfikatu zgodności". To klasyczne planowane postarzanie produktu, przeniesione z poziomu zmęczenia materiału na poziom architektury procesora.

Ostatnim gwoździem do trumny taniego PC jest inflacja materiałowa i energetyczna. Nowe standardy zasilania, takie jak ATX 3.1 ze zmodyfikowanymi, bezpieczniejszymi wtyczkami 12V-2x6, stały się koniecznością przy prądożernych GPU. Zasilacze o mocy 1000 watów, posiadające certyfikaty sprawności Titanium lub Platinum, są dziś fundamentem stabilnego zestawu. Należy pamiętać, że transformatory i okablowanie to czysta miedź, której ceny na rynkach światowych biją rekordy ze względu na konkurencję ze strony branży aut elektrycznych i OZE. W efekcie zasilacz kosztuje dziś tyle, ile dawniej przyzwoita karta graficzna ze średniej półki. Dzisiaj więc budowa solidnego, gamingowego PC to walka z systemowym wzrostem cen każdego grama miedzi i każdego centymetra krzemu.

Technologiczna nekromancja i pułapka VRAM. Strategia wymuszonej obsolescencji

Najbardziej niepokojącym sygnałem zapaści rynku nie są ceny, lecz zjawisko technologicznej nekromancji. Korporacyjna kalkulacja NVIDIA jest chłodna i bezlitosna: wykorzystanie cennych wafli w litografii 3 nm do produkcji tanich układów jest ekonomicznym samobójstwem. Dlatego zamiast nowej generacji budżetowej, otrzymujemy rynkowe "zombie" - wznowienie produkcji układów pokroju RTX 3060. To decyzja czysto księgowa: linie produkcyjne Samsunga (proces 8 nm) są dawno zamortyzowane, a koszt wytworzenia czipa groszowy. W rezultacie "nowy" komputer entry-level w 2026 roku to w istocie technologiczny skansen pudrowany marketingiem. Nie jest to stagnacja, lecz świadomy regres - branża woli cofnąć się o sześć lat, niż obciążać nowoczesne moce produkcyjne towarem o niskiej marży, zarezerwowanym dla AI.

Równie brutalna gra toczy się w segmencie średnim, gdzie ostatecznie pogrzebano nadzieje na standaryzację 16 GB VRAM. Anulowanie modeli RTX 5060 Ti i 5070 Ti w wariantach z powiększoną pamięcią oraz powrót do 8 GB w mainstreamie to podręcznikowy przykład inżynierii planowanego postarzania. W obliczu deficytu kości pamięci, producenci stosują agresywny upselling. Celowo likwidują "złoty środek" - karty wydajne i przyszłościowe - stawiając konsumenta przed binarnym wyborem: zakup "kastrata", który zadławi się nowoczesnymi teksturami w ciągu roku, lub drenujący portfel skok na głęboką wodę serii 5080/5090. Klasa średnia sprzętu nie umarła śmiercią naturalną - zostanie po cichu zlikwidowana, by chronić marże segmentu premium.

Ten sam mechanizm "shrinkflacji" (czyli płacenia więcej za mniej) zdewastował rynek mobilny. Prognozy o 24 GB RAM we flagowcach rozbiły się o ścianę rzeczywistości "Szoku Microna". Pamięć operacyjna stała się zbyt cennym zasobem, by montować ją "na zapas" w urządzeniach konsumenckich. Zatrzymanie się na 12 GB, a w wielu przypadkach powrót do 8 GB w smartfonach z górnej półki, to bezpośredni skutek drenażu podzespołów przez centra danych. Po raz pierwszy w historii IT nowa generacja sprzętu zaoferuje w kluczowych parametrach mniej niż poprzednia, będąc jednocześnie droższą w produkcji i zakupie.

Patrząc na krajobraz rynku w 2026 roku, należy wyzbyć się złudzeń o pęknięciu rzekomej bańki spekulacyjnej. To, z czym mamy do czynienia, to nie chwilowa anomalia podaży, lecz trwały, strukturalny reset kosztów bazowych, wynikający z globalnej walki o zasoby obliczeniowe. Era powszechnego, taniego dostępu do najnowszych technologii w domowym zaciszu definitywnie dobiegła końca. Komputer osobisty o wysokiej wydajności przestał być demokratyczną platformą rozrywki, a wrócił do roli, którą pełnił w latach dziewięćdziesiątych - skomplikowanego, kapryśnego i przede wszystkim drogiego narzędzia dla wąskiej elity. "Tani PC" nie zniknął przez chciwość jednego producenta; został wyparty przez fizykę produkcji półprzewodników i ekonomiczny dyktat sztucznej inteligencji, która za ten sam wafel krzemowy płaci dziesięciokrotnie więcej niż gracz.

W konsekwencji rynek uległ nieodwracalnej, binarnej polaryzacji. Zniknęła klasa średnia, będąca przez dekady motorem napędowym branży, ustępując miejsca przepaści między luksusowymi stacjami roboczymi, a terminalami dostępowymi. Dla masowego odbiorcy pojęcie "posiadania" sprzętu staje się ekonomicznie nieuzasadnione, wymuszając migrację ku usługom abonamentowym i graniu w chmurze. W 2026 roku własność fizyczna wydajnego hardware'u - miedzi, krzemu i lokalnej pamięci - stała się ostatecznym wyznacznikiem statusu majątkowego, oddzielającym cyfrowy plebs, skazany na streaming i opóźnienia, od technologicznej arystokracji.

Przeczytaj również

Komentarze (63)

SORTUJ OD: Najnowszych / Najstarszych / Popularnych