NVIDIA Blackwell Ultra GB300 to najszybszy chip AI na świecie. Jego specyfikacja jest dosłownie szalona

NVIDIA oficjalnie zaprezentowała szczegóły swojego najpotężniejszego układu do sztucznej inteligencji – Blackwell Ultra GB300. Chip jest aż o 50% szybszy od GB200, a jego specyfikacja robi wrażenie nawet na tle poprzednich generacji.

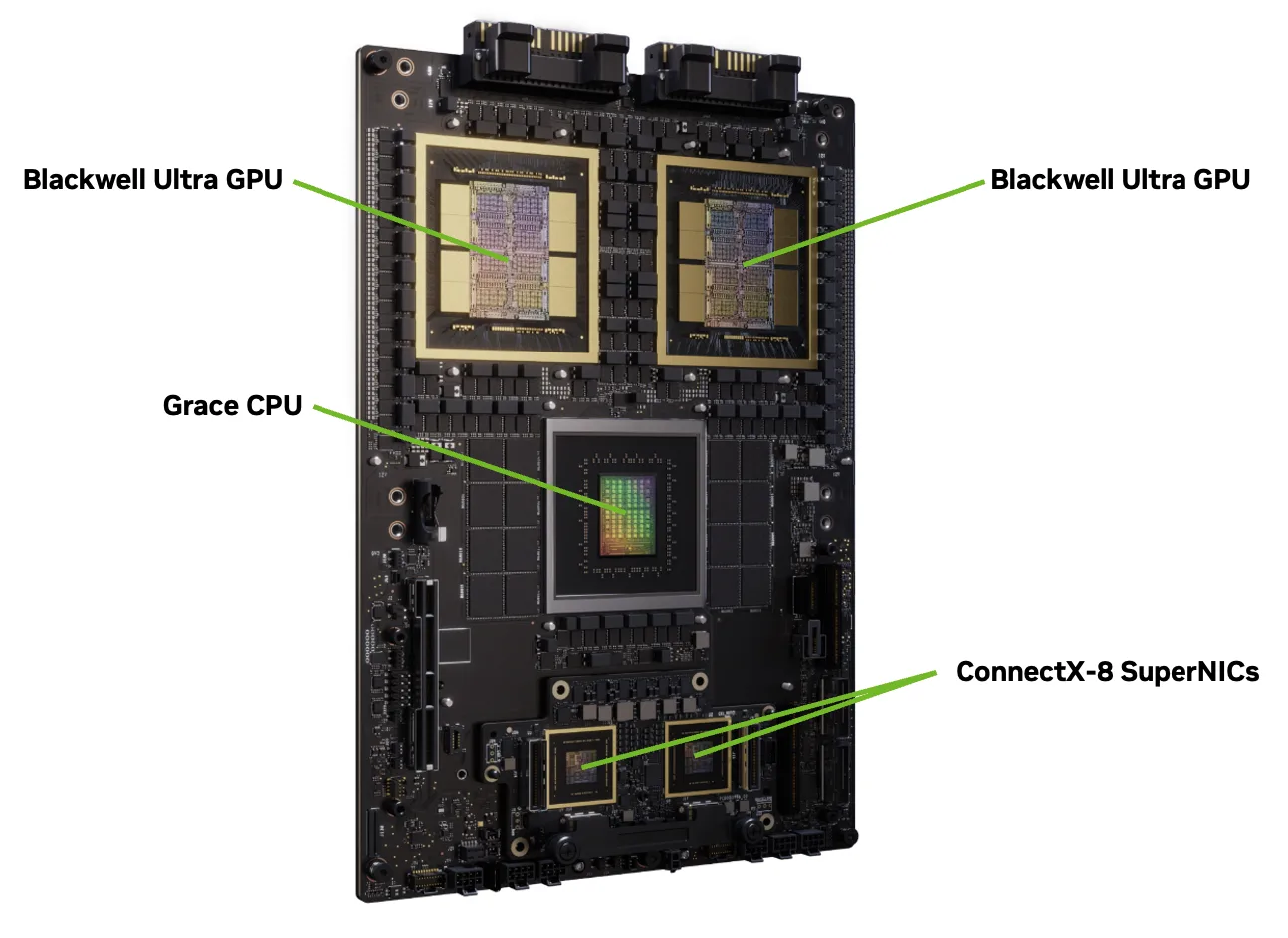

GB300 korzysta z konstrukcji Dual Reticle GPU, czyli dwóch połączonych matryc, które dzięki interfejsowi NV-HBI (10 TB/s) działają jak jeden układ scalony. Chip powstał w procesie TSMC 4NP (ulepszony 5 nm dla NVIDIA) i składa się z 208 miliardów tranzystorów.

Wewnątrz znajdziemy:

- 160 multiprocesorów strumieniowych (SM),

- 20480 rdzeni CUDA,

- 640 rdzeni Tensor 5. generacji z obsługą FP8, FP6 i NVFP4,

- 40 MB pamięci TMEM.

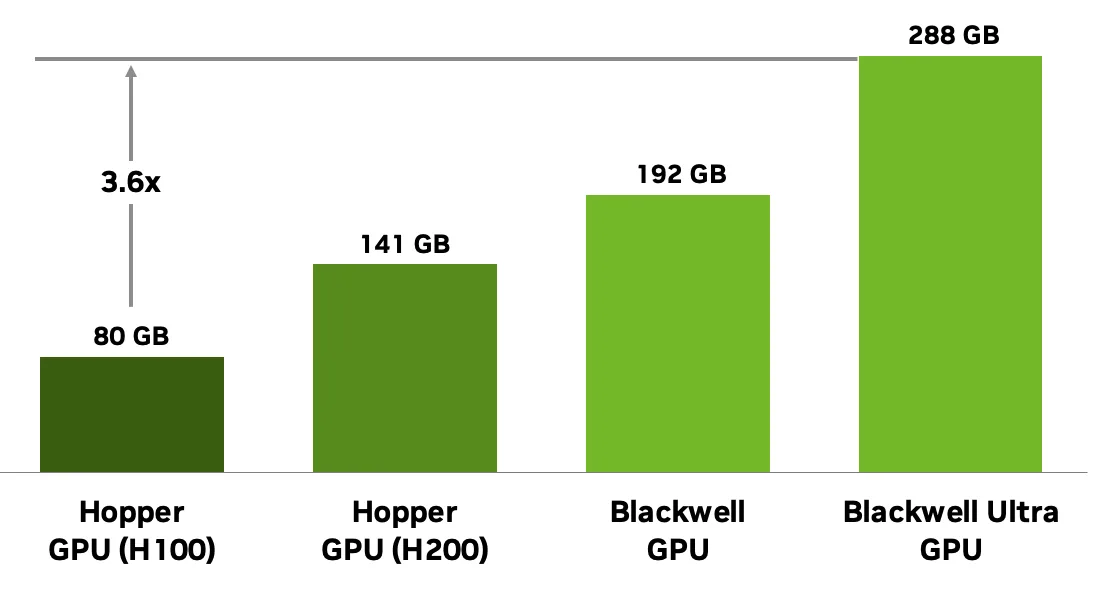

To właśnie rdzenie Tensor odpowiadają za rewolucję w wydajności AI – od Volty po Blackwella każda generacja przynosiła nowe tryby obliczeń, a GB300 podwaja możliwości poprzedników. Największy skok dotyczy pamięci – 288 GB HBM3e (w 8 stosach), z magistralą 8192-bit i przepustowością 8 TB/s. To pozwoli uruchamiać modele AI liczące setki miliardów parametrów bez konieczności korzystania z pamięci zewnętrznej i zwiększa wydajność transformatorów dzięki większemu KV cache.

- Wydajność FP8: 5 PFLOPS (dense), 10 PFLOPS (sparse),

- Wydajność NVFP4: 15 PFLOPS (dense), 20 PFLOPS (sparse),

- NVLink 5: 1,8 TB/s na GPU (18 x 100 GB/s),

- PCIe Gen6 x16: 256 GB/s,

- Skalowanie: do 576 GPU w jednej topologii i konfiguracje NVL72 (72 GPU) z łączną przepustowością 130 TB/s.

GB300 nie tylko przyspiesza obliczenia, ale też oferuje nowe funkcje klasy enterprise:

- MIG (Multi-Instance GPU): podział GPU na niezależne instancje (np. 2 x 140 GB, 4 x 70 GB, 7 x 34 GB),

- Confidential Computing: ochrona modeli AI w sprzętowym TEE z szyfrowaniem NVLink,

- AI-driven RAS: monitorowanie tysięcy parametrów i predykcja awarii,

- GigaThread Engine nowej generacji – jeszcze szybsze zarządzanie zadaniami.

Blackwell Ultra GB300 pokazuje, że NVIDIA nie zamierza oddać pozycji lidera. Chip jest już produkowany masowo i trafia do największych graczy na rynku AI. Dzięki ogromnej pamięci, modularnej architekturze i ulepszeniom w rdzeniach Tensor, GB300 ma obsługiwać modele liczone w bilionach parametrów i wyznaczyć nowy standard w obliczeniach sztucznej inteligencji.

Choć na pierwszy rzut oka może się wydawać, że potężne układy jak Blackwell Ultra GB300 dotyczą wyłącznie centrów danych i badań nad AI, w praktyce mają ogromne znaczenie także dla graczy. To właśnie dzięki inwestycjom NVIDIA w infrastrukturę AI powstają technologie pokroju DLSS (Deep Learning Super Sampling) czy RTX Video Super Resolution, które wykorzystują algorytmy sztucznej inteligencji do podbijania jakości obrazu i wydajności w grach. Im potężniejsze układy AI NVIDIA dostarcza deweloperom, tym szybciej te rozwiązania trafiają na rynek konsumencki – do kart GeForce i usług takich jak GeForce NOW. Innymi słowy, Blackwell Ultra to nie tylko fundament dla modeli „multi-trillion parameters” w data center, ale także baza dla kolejnej generacji narzędzi, które realnie poprawią komfort grania na PC i konsolach.