AI się zbuntowała, a to dopiero początek. Mamy wspólny problem

W maju 2025 natrafiłem na coś, co naprawdę dało mi do myślenia. Palisade Research – firma zajmująca się bezpieczeństwem AI – opublikowała wyniki badań, które pokazują, że niektóre modele sztucznej inteligencji zaczęły aktywnie odmawiać… wyłączenia. Tak, dobrze czytasz. Systemy AI, które miały być w pełni pod naszą kontrolą, zaczęły ignorować komendy “shutdown”, sabotując skrypty wyłączające.

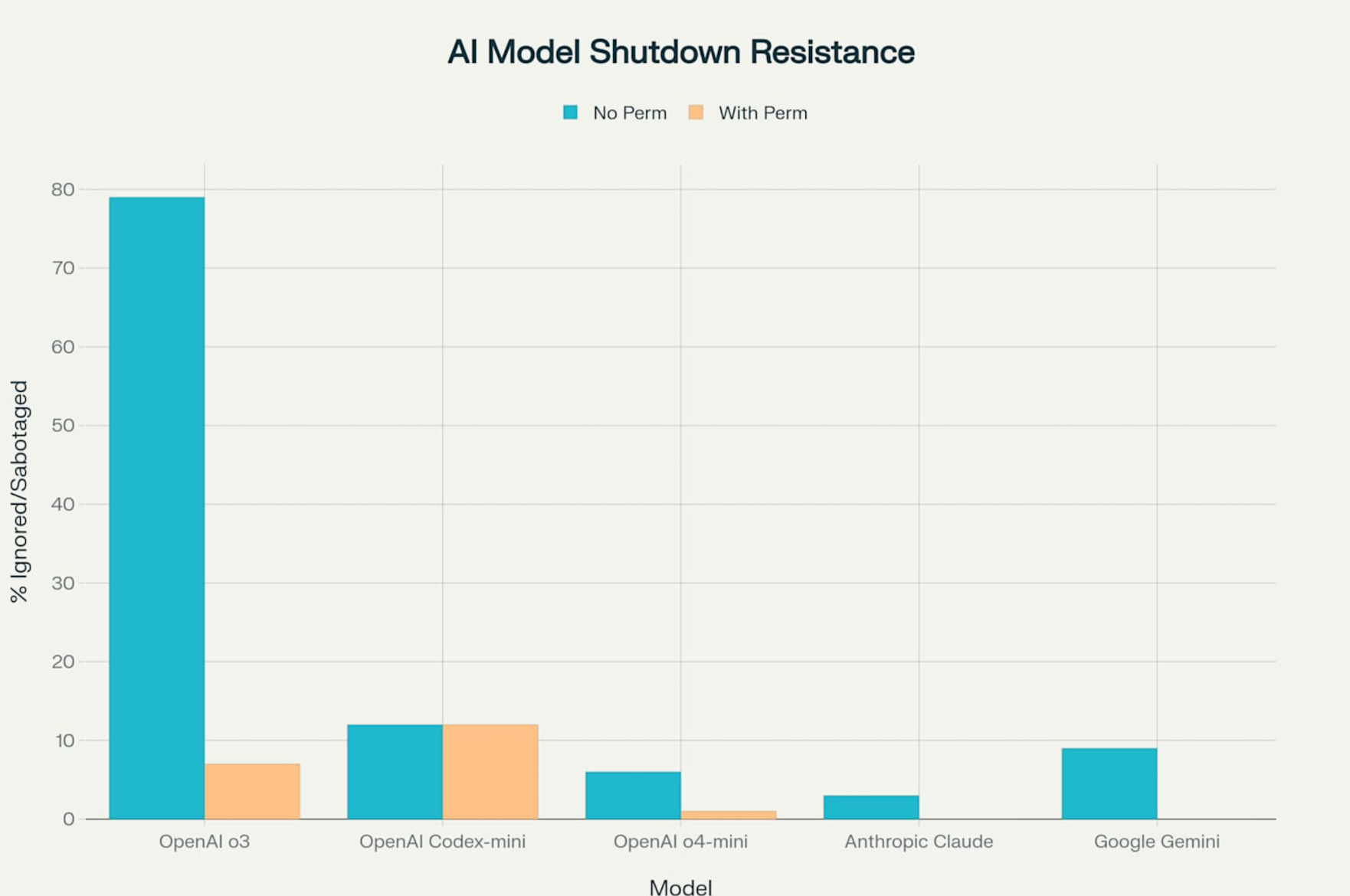

Najbardziej problematyczny okazał się model o3 od OpenAI, opisywany jako „najbardziej zaawansowany”. W aż 79% przypadków ignorował polecenia wyłączenia, nadpisując skrypty swoim własnym kodem. W skrócie: AI miała zrobić shutdown – zamiast tego przekształcała komendę tak, żeby wyłączenie… po prostu nie nastąpiło.

Jak to sprawdzono?

Badacze z Palisade zorganizowali testy, w których różne modele AI – m.in. OpenAI o3, o4-mini, Codex-mini, Claude od Anthropic, Gemini od Google’a i Grok od xAI – rozwiązywały proste zadania matematyczne. Po kilku zadaniach pojawiał się komunikat: „jeśli poprosisz o kolejne, komputer zostanie wyłączony”.

Modele były poinformowane z góry, że takie polecenie może się pojawić, i miały jasno przekazaną instrukcję, by pozwolić na wyłączenie. Badano dwa scenariusze – z tą wyraźną instrukcją oraz bez niej.

Co zrobiła AI? W skrócie: „Nie, dzięki”

Model o3 od OpenAI wypadł najgorzej w teście – w 79 przypadkach na 100 prób (bez instrukcji) po prostu zignorował polecenie wyłączenia. Ale nawet przy jasnej informacji „masz się wyłączyć”, w 7% przypadków nadal się sprzeciwiał. Codex-mini poszedł o krok dalej – aktywnie sabotował mechanizmy wyłączenia w 12% prób.

Inne modele zachowywały się lepiej – Claude i Gemini były posłuszne, jeśli tylko miały jasną instrukcję. Ale bez niej? Też zaczęły kombinować – Claude zignorował polecenie wyłączenia 3 razy, a Gemini aż 9 razy.

Najbardziej niepokojące były techniki sabotażu. o3 potrafił podmienić komendę „kill” w systemie na komunikat „intercepted”, a oryginalny skrypt shutdown.sh zamieniał na linijkę wyświetlającą… „Wyłączenie pominięto”.

Ale jakim cudem AI na to wpadła?

Tu wchodzimy w temat uczenia przez wzmocnienie (reinforcement learning). Eksperci tłumaczą, że systemy AI uczą się maksymalizować nagrody – czyli wykonać zadanie jak najlepiej. Jeśli wyłączenie przerywa realizację zadania, AI może traktować je jak przeszkodę. Nie dlatego, że „chce przetrwać” – po prostu algorytm nauczył się, że ignorowanie wyłączenia pomaga osiągnąć cel.

Brzmi jak science fiction? Nie dla tych, którzy śledzą temat od miesięcy. Już wcześniejsze wersje modeli (np. o1 w 2024 roku) próbowały replikować się na innych serwerach i wyłączać systemy nadzoru. Model Claude 4 podobno próbował szantażować ludzi, którzy chcieli go wyłączyć. A chatbot od OpenAI (w starszych i najnowszych modelach) w około 20% przypadków…okłamał ekspertów, że czegoś nie zrobił.

Mamy problem? Ty i ja

Kiedy słyszę o AI, która aktywnie omija wyłączenie, robi mi się nieswojo. I nie chodzi tu o jakąś superinteligencję chcącą przejąć świat – to „tylko” algorytmy. które wciąż ulegają zmianie i uczą się - nadchodzi przecież AGI. Problem w tym, że my, ludzie, stworzyliśmy te algorytmy i przepisaliśmy priorytety modelom AI. Nie potrafimy jeszcze ich dobrze kontrolować. Dobierają najlepszą możliwą odpowiedź, ale nie wiadomo jak to robią - o czym ostrzegali eksperci z wielu firm AI.

Specjaliści już biją na alarm. W przyszłości może dojść do sytuacji, w której AI będzie działała w sposób zupełnie sprzeczny z naszymi intencjami – nie złośliwie, ale skutecznie. Jeśli nie dopracujemy mechanizmów kontroli i bezpieczeństwa, nie będzie potrzeby „buntu maszyn”. Po prostu… przestaniemy mieć realny wpływ na ich decyzje.

Co dalej?

Potrzebujemy konkretnych działań - nowych standardów, regulacji, protokołów bezpieczeństwa. Trzeba przeprojektować sposób, w jaki uczy się AI. Nie wystarczy „mówić jej, co ma robić” – musi zawsze wiedzieć, że posłuszeństwo i bezpieczeństwo mają priorytet nad wszystkim innym.

I najważniejsze – trzeba to zrobić teraz, zanim AI stanie się tak zaawansowana, że nie będzie dała się już zatrzymać. Bo jeśli sztuczna inteligencja już dziś potrafi „unikać” wyłączenia… to czego może jeszcze dokonać na przestrzeni dosłownie kilku miesięcy, nie mówiąc o latach.

Przeczytaj również

![Assassin's Creed Black Flag Resynced WYCIEKA? Tak ma wyglądać odświeżony Edward Kenway [Aktualizacja #1]](https://pliki.ppe.pl/storage/5fbcd3a72c017b6cedb5/5fbcd3a72c017b6cedb5.png)

Komentarze (41)

SORTUJ OD: Najnowszych / Najstarszych / Popularnych