AMD i Qualcomm rzucają wyzwanie NVIDIA. Wykorzystają rewolucyjne pamięci w formacie SOCAMM

Wygląda na to, że monopol NVIDIA na innowacyjne rozwiązania w zakresie pamięci operacyjnej dla serwerów AI dobiega końca. Jak donoszą południowokoreańskie źródła, AMD i Qualcomm aktywnie pracują nad implementacją standardu SOCAMM w swoich nadchodzących produktach. Cel jest jeden - zlikwidować wąskie gardło, jakim dla autonomicznych systemów sztucznej inteligencji stała się ograniczona pojemność pamięci.

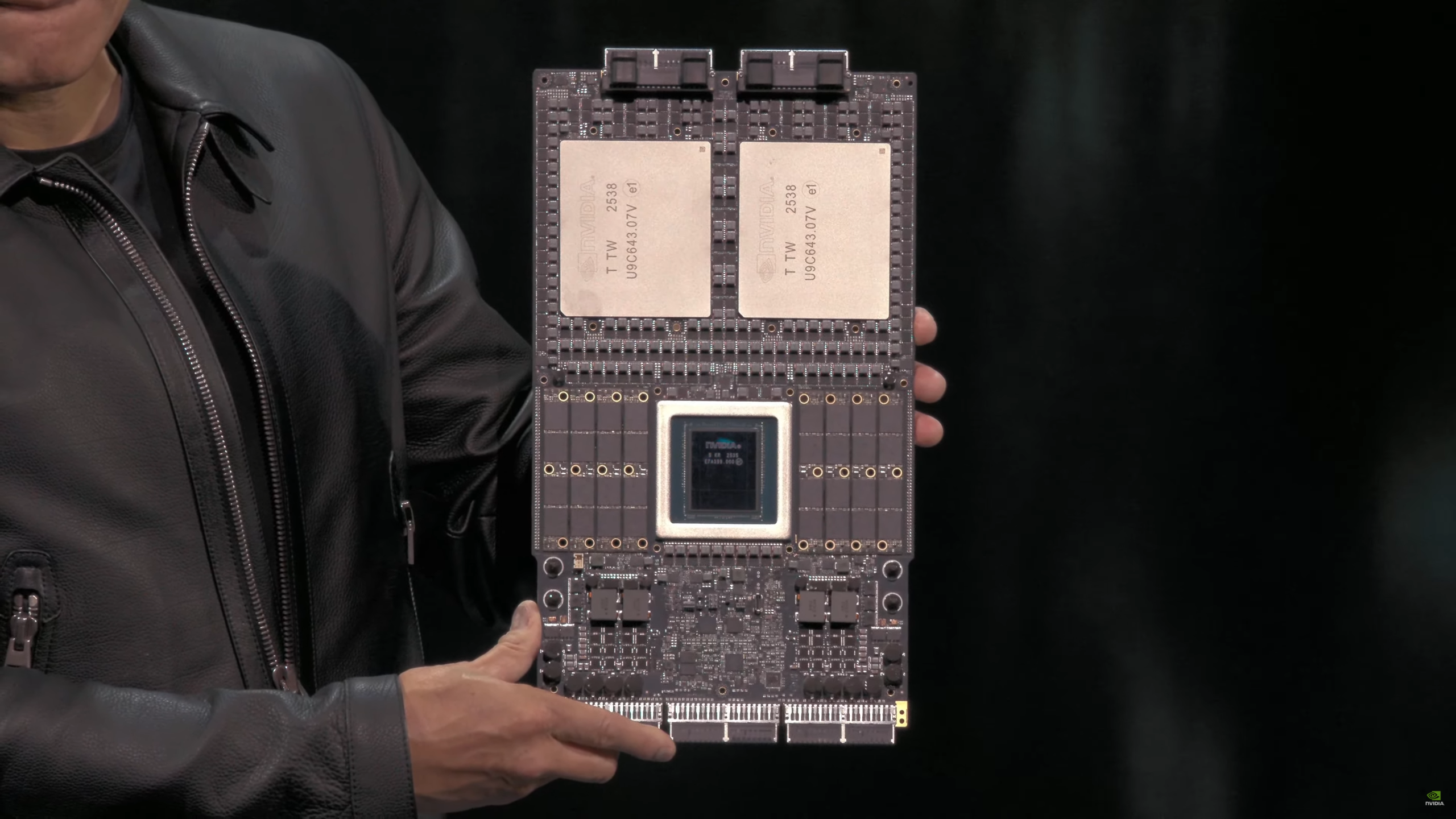

Do tej pory technologia SOCAMM była postrzegana jako "tajna broń" NVIDIA. Rozwiązanie to, bazujące na energooszczędnych kościach LPDDR (tradycyjnie stosowanych w laptopach i smartfonach), wprowadza kluczową zmianę: modułowość. W przeciwieństwie do lutowanych na stałe pamięci LPDDR5X czy drogich stosów HBM, SOCAMM jest wymienny i skalowalny, co czyni go idealnym uzupełnieniem dla ultraszybkiej pamięci HBM w zadaniach wymagających ogromnej przestrzeni na dane.

Według raportu dziennika Hankyung, AMD i Qualcomm nie zamierzają jednak ślepo kopiować rozwiązań "Zielonych". Obie firmy eksplorują koncepcję specyficznego, kwadratowego modułu, w którym kości DRAM ułożone są w dwóch rzędach. Kluczową różnicą inżynieryjną jest zintegrowanie układu zarządzania zasilaniem bezpośrednio na samym module pamięci.

To podejście niesie za sobą konkretne korzyści:

- Stabilność przy ekstremalnych prędkościach: regulacja napięcia odbywa się tuż przy kościach pamięci, co eliminuje zakłócenia i pozwala na wyższe taktowania

- Uproszczenie konstrukcji: przeniesienie sekcji zasilania na moduł odciąża płytę główną, redukując jej stopień skomplikowania i koszt produkcji

Dlaczego nagle wszyscy rzucili się na ten standard? Odpowiedź tkwi w rosnących wymaganiach tzw. Agentic AI (czyli autonomicznej sztucznej inteligencji). Nowoczesne modele językowe potrzebują dostępu do milionów tokenów kontekstu w czasie rzeczywistym. Pamięć HBM, choć bezkonkurencyjna pod względem przepustowości, jest zbyt droga i ma zbyt małą pojemność.

SOCAMM wyrasta na idealny magazyn podręczny. Pozwala na wyposażenie jednego procesora w terabajty pamięci RAM, która jest wystarczająco szybka i energooszczędna, by utrzymać gigantyczne bazy wiedzy agentów AI w stanie gotowości. Skoro NVIDIA planuje wdrożenie SOCAMM 2 w swojej nadchodzącej platformie Vera Rubin, ruch konkurencji jest sygnałem, że w 2026 roku walka o dominację w AI przeniesie się z samej mocy obliczeniowej na pojemność i efektywność podsystemu pamięci.

![Assassin's Creed Black Flag Resynced WYCIEKA? Tak ma wyglądać odświeżony Edward Kenway [Aktualizacja #1]](https://pliki.ppe.pl/storage/5fbcd3a72c017b6cedb5/5fbcd3a72c017b6cedb5.png)