WWDC25: Apple zaprezentowało iOS 26. Największy redesign od czasów iOS 7 - nowy „Liquid Glass” interfejs!

Podczas keynote otwierającego WWDC 2025 Apple oficjalnie zaprezentowało system iOS 26, który – zgodnie z zapowiedziami – wprowadza największą wizualną zmianę od czasu iOS 7. Nowy interfejs, określany jako „Liquid Glass”, czerpie garściami z estetyki visionOS: pełno w nim przezroczystości, świetlnych efektów, dynamicznych warstw i materiałów przypominających szkło. Apple określa go jako swoją „najszerzej zakrojoną aktualizację designu w historii”.

Prezentację systemu poprzedziło wideo otwierające z Craigiem Federighim w bolidzie F1 – nawiązując do nowego CarPlay i filmu o Formule 1, który zadebiutuje na Apple TV+. Po tym, jak na scenie pojawili się Tim Cook i Craig, ogłoszono oficjalnie zmianę numeracji systemów – wszystkie platformy Apple w 2025 roku będą oznaczone numerem 26: iOS 26, iPadOS 26, macOS 26, watchOS 26, tvOS 26 oraz visionOS 26. Tak, jak spekulowano wcześniej - wszystko się potwierdziło.

Craig Federighi rozpoczął od prezentacji nowego interfejsu. iOS 26 wprowadza nową warstwę wizualną przypominającą „szklane kafelki” – z dynamicznymi tłami, płynnymi przejściami i przezroczystymi panelami. Toolbary chowają się automatycznie przy scrollowaniu, a nowy system ikon – mimo że odświeżony – zachowuje znajome kształty (i nie są one okrągłe, jak wcześniej spekulowano). Ekran blokady i home screen są bardziej ekspresyjne – tapety mogą dynamicznie reagować na treść, zegar dopasowuje swój układ do grafiki w tle, a zdjęcia mają wyraźny efekt 3D. Nawet albumy muzyczne na ekranie blokady są teraz animowane.

Przeprojektowano też interfejs Safari – z nowym, szklistym paskiem zakładek – oraz uproszczono aplikację Aparatu, w której przełączanie się między zdjęciami, a wideo odbywa się teraz przez prosty gest przesunięcia. Zaawansowane tryby, jak Cinematic czy Panorama, są dostępne w osobnym, rozwijanym menu (wystarczy na dole przesunąć dalej w prawo lub w lewo). Aplikacja Zdjęcia otrzymała z kolei uproszczony układ z podziałem na bibliotekę i albumy – co klienci z pewnością przyjmą z entuzjazmem, jako poprawkę do krytykowanych zmian z zeszłego roku.

W aplikacji Phone zaprezentowano nowy układ: ulubione kontakty są na górze, poniżej historia połączeń i wiadomości głosowych, a Apple Intelligence podpowiada streszczenia z voicemaili (niestety ta funkcja nadal nie będzie dostępna w Polsce). Ten sam styl interfejsu pojawia się również w CarPlay – teraz bardziej spójny, z nowymi widgetami, powiadomieniami na żywo i ciemnym trybem w aplikacjach. To wszystko ma trafić do wersji CarPlay Ultra – czyli systemu przejmującego cały interfejs samochodu.

Apple zapowiedziało też pierwsze kroki w kierunku integracji Apple Intelligence – nowej platformy AI. W iOS 26 zobaczyliśmy m.in. funkcje takie jak Genmoji, Image Playground, przetwarzanie tekstu i streszczenia powiadomień. Craig przyznał jednak wprost, że większe zmiany – takie jak nowa Siri – potrzebują więcej czasu i zadebiutują dopiero w przyszłym roku.

Po wprowadzeniu do systemu iOS 26 i nowego interfejsu Liquid Glass, Apple przeszło do funkcji komunikacyjnych. Darin Adler zaprezentował zmiany w aplikacji Telefon. Jedną z ważniejszych nowości jest zaawansowane rozpoznawanie połączeń przychodzących z nieznanych numerów. Dzięki Apple Intelligence, system automatycznie analizuje treść zgłoszenia i prezentuje na ekranie streszczoną informację o celu połączenia – zanim użytkownik zdecyduje, czy chce odebrać. To rozszerzenie dotychczasowego systemu voicemail, z pominięciem konieczności odsyłania rozmówcy na pocztę głosową. Na ekranie połączeń pojawił się też nowy, uproszczony layout.

Następnie Adler przeszedł do aplikacji Wiadomości, która również doczekała się kilku oczekiwanych usprawnień. Do grupowych czatów trafiają długo wyczekiwane ankiety – użytkownicy mogą teraz tworzyć pytania z wieloma opcjami, a uczestnicy rozmowy mogą dodawać własne odpowiedzi. W wiadomościach grupowych pojawiły się też wskaźniki pisania, które dotąd działały tylko w rozmowach jeden na jeden. Co więcej, możliwe jest teraz przesyłanie Apple Cash bezpośrednio w czacie grupowym.

Wprowadzono również nową funkcję wspólnych przestrzeni rozmów – tła konwersacji można dostosować, wybierając z gotowych dynamicznych motywów, własnych zdjęć, a nawet grafik generowanych przez Apple Intelligence. Te zmiany idą w parze z aktualizacjami Genmoji – użytkownicy mogą teraz tworzyć własne emoji, łącząc istniejące z dodatkowymi opisami (np. „mikrofon w cekinowej marynarce”). Image Playground, narzędzie do generowania obrazów, zyskało wsparcie dla zewnętrznych integracji – deweloperzy mogą korzystać z nowego API, a użytkownicy mają dostęp do nowych stylów, m.in. realistycznych grafik, np. do zaproszeń.

W dalszej części prezentacji Leslie Ikemoto ogłosiła funkcję "Tłumacza na żywo". Tłumaczenia w czasie rzeczywistym zostały wbudowane bezpośrednio w aplikacje Wiadomości, FaceTime oraz Telefon. W przypadku wiadomości tekstowych tłumaczenie pojawia się nad klawiaturą, jeszcze przed wysłaniem. Podczas rozmów wideo, FaceTime może teraz nakładać na ekran napisy w czasie rzeczywistym, a w zwykłych połączeniach głosowych system tłumaczy wypowiedzi użytkownika po zakończeniu jego kwestii – co może być przydatne np. podczas rezerwowania usług w językach obcych.

Deweloperzy otrzymali dostęp do nowego API umożliwiającego integrację tłumaczenia na żywo we własnych aplikacjach, co otwiera drogę do tłumaczeń w grach, komunikatorach czy aplikacjach edukacyjnych. Po prezentacji zmian w komunikacji i AI, głos ponownie zabrał Craig Federighi, który zapowiedział nowości w usługach – w tym Apple Music, Mapach oraz Portfelu – i przekazał scenę dalej, do Kathy Lin odpowiedzialnej za inżynierię oprogramowania w działach usług.

Po omówieniu systemowych nowości w iOS 26, Apple przeszło do segmentu usług. Kathy Lin zaprezentowała nowości w Apple Wallet, Apple Maps, Apple Music oraz – po raz pierwszy w tej formie – platformę gier pod nazwą Apple Games.

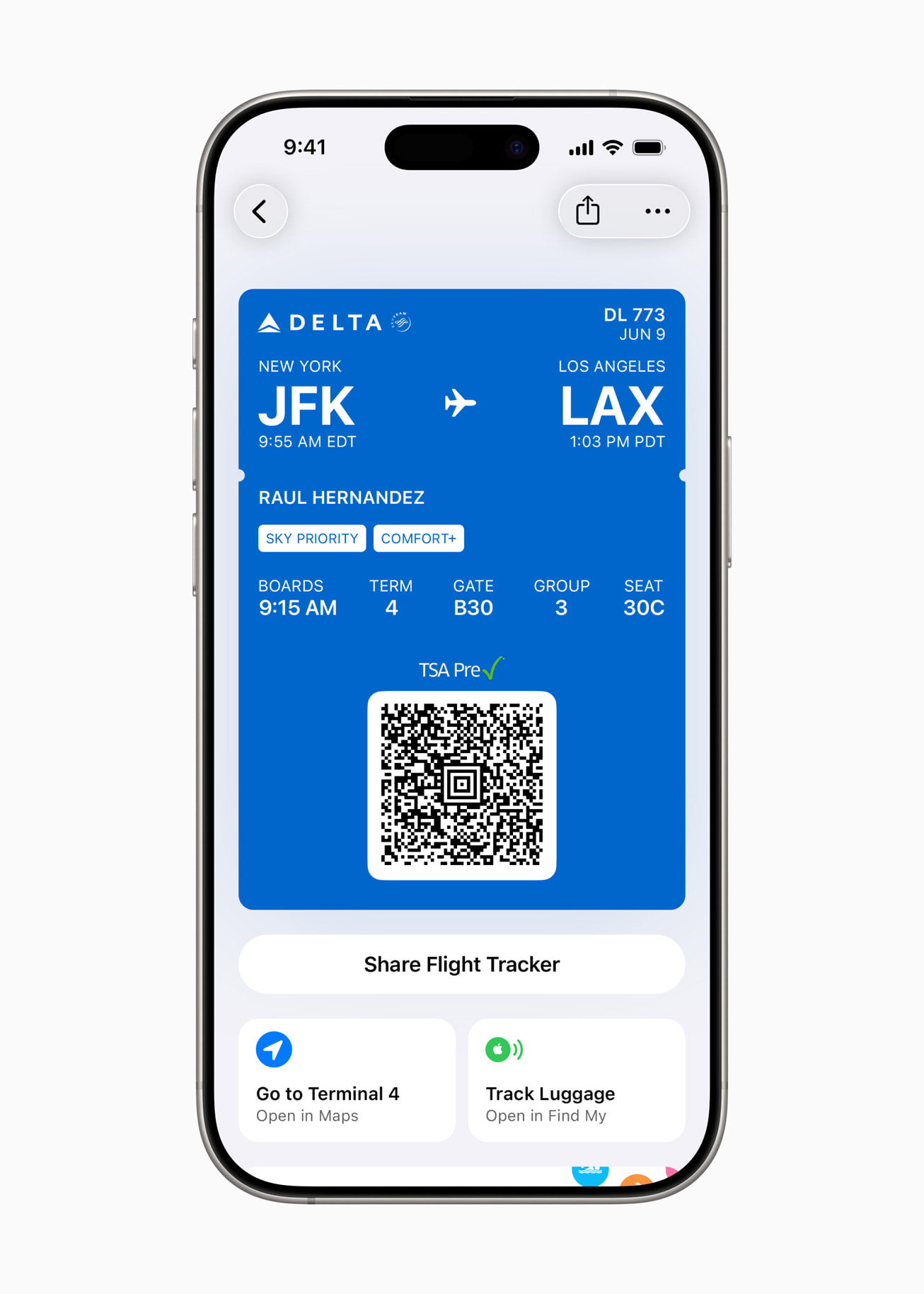

W aplikacji Portela wprowadzono możliwość tworzenia cyfrowej tożsamości na podstawie paszportu. Nie zastępuje ona dokumentu, ale może być wykorzystywana w sytuacjach wymagających potwierdzenia wieku lub tożsamości – np. na lotniskach czy w hotelach. Portfel potrafi teraz też analizować powiadomienia transakcyjne, niezależnie od tego, czy zakupy były realizowane przez Apple Pay. System automatycznie rozpoznaje treść, porządkuje zamówienia i śledzi przesyłki.

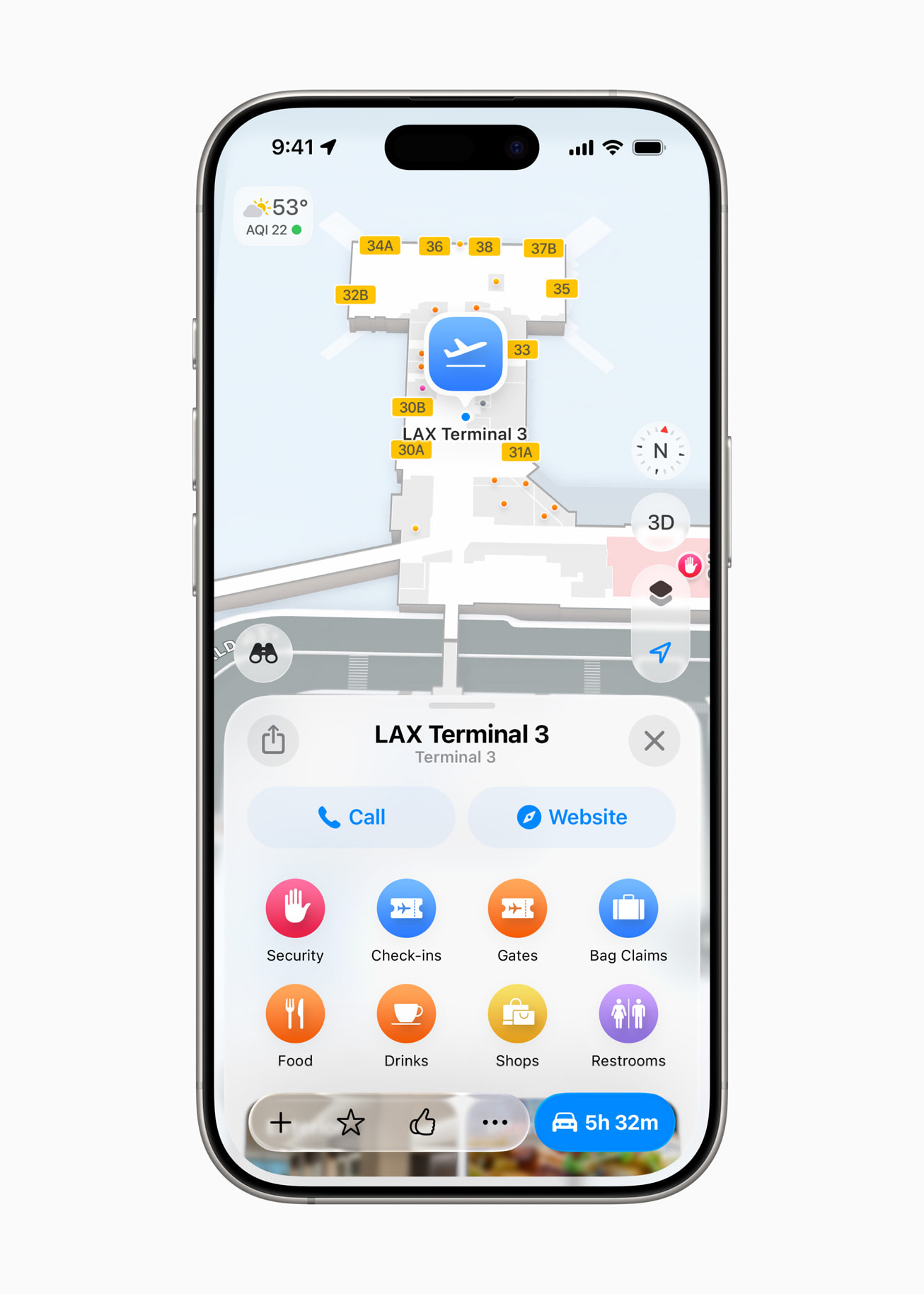

Mapy Apple zyskały funkcję „Odwiedzonych Miejsc" – nową, prywatną historię odwiedzanych lokalizacji. Wszystko działa lokalnie, z szyfrowaniem end-to-end, a dane można w każdej chwili usunąć. System uczy się też codziennych tras użytkownika i reaguje na zmiany w jego rutynie. Nowe opcje tras wieloetapowych mają wspierać codzienne planowanie – np. odwożenie dzieci do szkoły, kawa i dojazd do pracy. Na papierze brzmi to świetnie, ale w Polsce w najbliższym czasie nie będzie dostępne.

W Apple Music pojawiła się opcja tłumaczenia tekstów piosenek w czasie rzeczywistym – z przewodnikami wymowy w językach obcych. Dodano też funkcję AutoMix, która automatycznie łączy utwory z dopasowaniem tempa i beatów, tworząc efekt płynnego miksu – przydatne np. na imprezach. W bibliotece muzycznej można teraz przypinać ulubionych wykonawców, albumy i playlisty na samej górze, podobnie jak przypinanie wiadomości czy kontaktów w innych aplikacjach Apple.

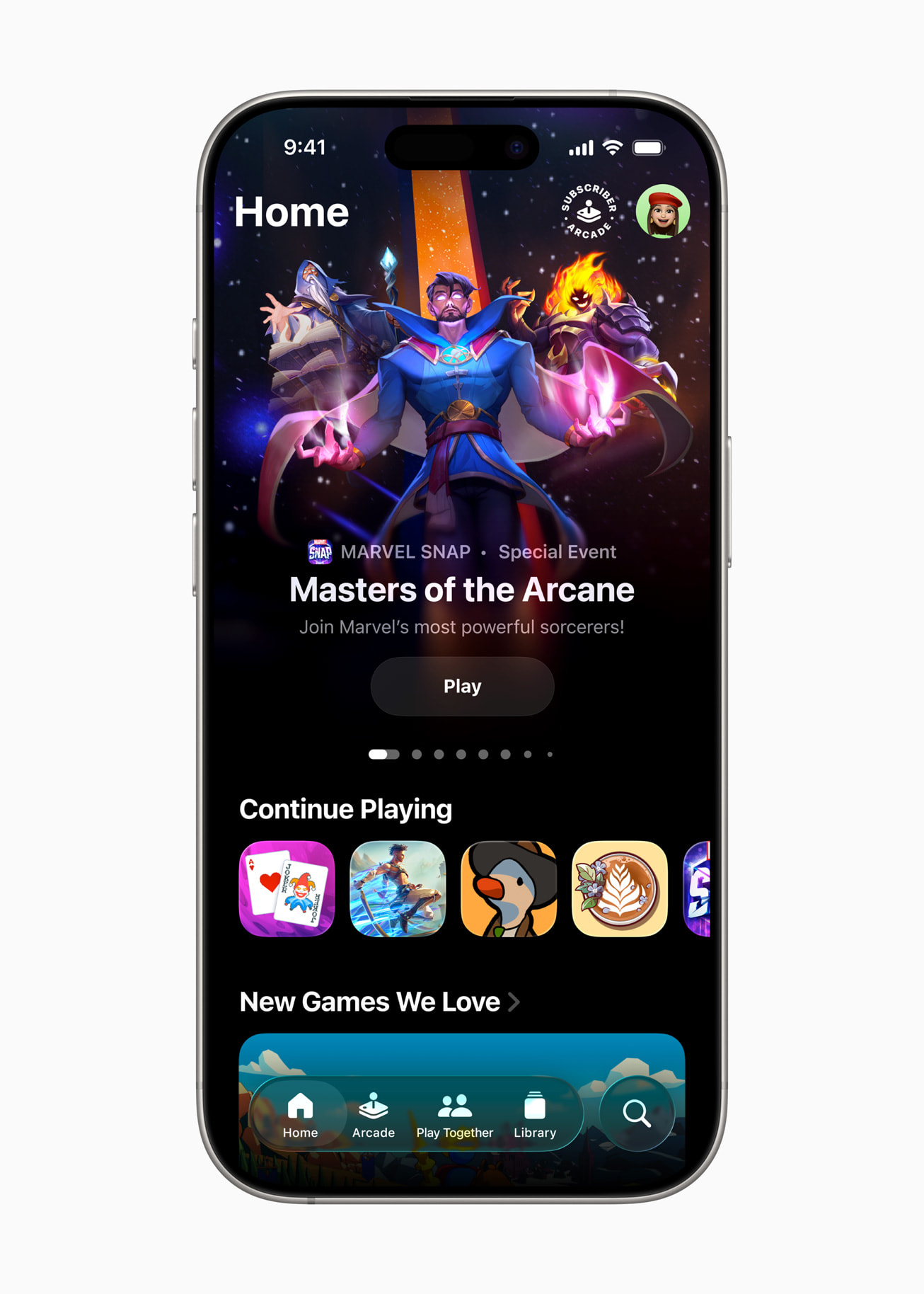

Wreszcie przyszła kolej na gry. Apple zaprezentowało nową aplikację Apple Games – centralne miejsce do zarządzania rozgrywką. W zakładce biblioteki użytkownicy zobaczą wszystkie gry, które kiedykolwiek pobrali z App Store – z możliwością szybkiego powrotu. Zakładka „Play Together” umożliwia podgląd tego, w co grają znajomi, ich osiągnięcia i aktualną aktywność. Nowa funkcja Challenges pozwala na rzucanie znajomym wyzwań w ramach tych samych tytułów. Wszystko to spięte jest z Apple Arcade, które zyskało osobną zakładkę.

Nowy iOS26 - Apple Games oraz zmiany w powiadomieniach w Portfelu

Zaraz potem Craig Federighi wrócił na scenę, by przedstawić kolejną ważną część ekosystemu Apple Intelligence – tzw. Visual Intelligence. To funkcja rozpoznająca zawartość obrazów na podstawie tego, co widzimy na ekranie lub w kadrze aparatu. Przykład: kierując kamerę na buty, użytkownik może otrzymać szczegółowe informacje o produkcie, linki do sklepów i podobne modele.

Podobnie działa to w przypadku zrzutów ekranu – jeśli zapiszesz grafikę z wydarzeniem, Apple Intelligence rozpozna datę, lokalizację i zaoferuje stworzenie zaproszenia w Kalendarzu. System działa też z zewnętrznymi źródłami. Podczas prezentacji pokazano, jak użytkownik może zrobić screenshot instrumentu (np. mandoliny) i poprosić OpenAI o polecenie piosenek, w których występuje ten instrument. Visual Intelligence integruje się także z API dla deweloperów, dzięki czemu aplikacje firm trzecich mogą korzystać z tych samych rozwiązań rozpoznawania kontekstu wizualnego.

Lada moment dostępna będzie deweloperska wersja beta iOS 26. Publiczna beta pojawi się w lipcu, a oficjalna premiera systemu zapowiedziana jest na wrzesień, razem z nowym iPhonem 17. Więcej szczegółów, informacji i wideo pokazowych znajdziecie na oficjalnej stronie Apple.